|

1гҖҒжЁЎеқ—з®Җд»Ӣ

зңӢй—ЁзӢ—/WdgжЁЎеқ—жҳҜдёҖдёӘзӢ¬з«Ӣзҡ„е®ҡж—¶еҷЁпјҢеҸҜз”ЁдәҺзі»з»ҹдҪҝз”ЁгҖӮе®ғзҡ„дҪңз”ЁжҳҜжҸҗдҫӣе®үе…ЁеҠҹиғҪд»ҘзЎ®дҝқиҪҜ件жҢүи®ЎеҲ’жү§иЎҢпјҢ并且CPUдёҚдјҡйҷ·е…Ҙж— йҷҗеҫӘзҺҜжҲ–жү§иЎҢж„ҸеӨ–зҡ„д»Јз ҒгҖӮеҰӮжһңWdgжЁЎеқ—еңЁдёҖе®ҡж—¶й—ҙеҶ…жңӘиў«и§ҰеҸ‘/еҲ·ж–°/е–ӮзӢ—пјҢе®ғе°ҶеӨҚдҪҚMCUгҖӮиҝҷжҳҜдёҖдёӘйқһеёёеёёз”ЁгҖҒйқһеёёйҮҚиҰҒзҡ„дёҖдёӘжЁЎеқ—гҖӮ

AUTOSAR MCAL WdgжЁЎеқ—дё»иҰҒжҸҗдҫӣд»ҘдёӢжңҚеҠЎ/APIпјҡ

- еҲқе§ӢеҢ–/Wdg_Init

- и®ҫзҪ®жЁЎејҸ/Wdg_SetMode

- и®ҫзҪ®и§ҰеҸ‘жқЎд»¶пјҲи®ҫзҪ®и¶…ж—¶ж—¶й—ҙ/е–ӮзӢ—пјү/Wdg_SetTriggerCondition

WdgйҖҡеёёжңүдёӨз§ҚпјҢдёҖз§ҚжҳҜиҠҜзүҮеҶ…йғЁиҮӘеёҰзҡ„зүҮеҶ…зңӢй—ЁзӢ—пјӣиҝҳжңүдёҖз§ҚжҳҜеңЁиҠҜзүҮеӨ–йғЁйҖҡиҝҮSPIиҝҷз§ҚжҺҘеҸЈиҝһжҺҘзҡ„зүҮеӨ–зңӢй—ЁзӢ—гҖӮMCALеҸӘиҙҹиҙЈз¬¬дёҖз§ҚзүҮеҶ…зңӢй—ЁзӢ—пјҢзүҮеҶ…зңӢй—ЁзӢ—зҡ„зү№зӮ№жҳҜWdgжЁЎеқ—жҳҜзӣҙжҺҘи®ҝй—®зӣёе…ізЎ¬д»¶еҜ„еӯҳеҷЁгҖӮзүҮеӨ–зңӢй—ЁзӢ—еұһдәҺжқҝзә§и®ҫеӨҮжҠҪиұЎеұӮиҙҹиҙЈпјҢйҖҡеёёйңҖиҰҒдҪҝз”ЁMCALжҸҗдҫӣзҡ„е…¶д»–жЁЎеқ—пјҲжҜ”еҰӮSPIзӯүпјүжқҘи®ҝй—®/жҺ§еҲ¶еӨ–жү©зңӢй—ЁзӢ—иҠҜзүҮгҖӮиҝҷз§ҚдёҚиғҪзӣҙжҺҘи®ҝ问硬件еҜ„еӯҳеҷЁгҖӮ

з”ұдәҺе…¶зү№ж®ҠжҖ§пјҢиҜҘжЁЎеқ—зҡ„д»Јз ҒйҷӨдәҶеҸҜд»ҘеңЁROMйҮҢйқўиҝҗиЎҢеӨ–пјҢд№ҹеҸҜиғҪдјҡеңЁRAMйҮҢйқўиҝҗиЎҢгҖӮжҜ”еҰӮеңЁBootloaderеҲ·еҶҷFlashж—¶пјҢWdgжЁЎеқ—еҸҜиғҪдҪңдёәдәҢиҝӣеҲ¶ж–Ү件йҮҢйқўзҡ„дёҖйғЁеҲҶеңЁRAMдёҠиҝҗиЎҢгҖӮ

жң¬ж–ҮеҶ…е®№еҹәдәҺзӣ®еүҚжңҖж–°зүҲеҚҸи®®пјҡR19-11

жіЁж„Ҹпјҡ

иҜҘжЁЎеқ—дёҚжҸҗдҫӣDeInitеҮҪж•°гҖӮеҰӮжһңзҡ„зЎ®йңҖиҰҒе…ій—ӯиҜҘжЁЎеқ—пјҢеҸҜйҖҡиҝҮи°ғз”ЁWdg_SetMode()еҮҪж•°пјҢеҸӮж•°дёәOFF ModeжқҘе®һзҺ°гҖӮ

дёҚжҸҗдҫӣDeInitеҮҪж•°зҡ„еҺҹеӣ дё»иҰҒжңүдёӨзӮ№пјҡ

1гҖҒеӣ дёәеҫҲеӨҡ硬件дёҚж”ҜжҢҒе…ій—ӯеҠҹиғҪгҖӮ

2гҖҒдёҖдәӣе®үе…ЁжҖ§иҰҒжұӮй«ҳзҡ„зі»з»ҹдёҚе…Ғи®ёе…ій—ӯзңӢй—ЁзӢ—гҖӮ

зүҮеҶ…е’ҢзүҮеӨ–иҝҷдёӨз§ҚдҪ“зі»з»“жһ„е·®ејӮеҜјиҮҙзҡ„й—®йўҳпјҢеңЁжңӘжқҘзҡ„зүҲжң¬дёӯжңүи®ЎеҲ’еҫ—еҲ°и§ЈеҶігҖӮ

е®һйҷ…жғ…еҶөпјҢеҸҜиғҪжңүдәӣеҺӮе•ҶеңЁWdgжЁЎеқ—йҮҢйқўе·Із»Ҹжү©еұ•дәҶпјҢд№ҹе°ұжҳҜеңЁйҮҢйқўд№ҹеҸҜд»Ҙй…ҚзҪ®еӨ–жҢӮзңӢй—ЁзӢ—гҖӮеҰӮжһңе·Із»Ҹжү©еұ•дәҶпјҢйҖҡеёёзүҮеҶ…е’ҢзүҮеӨ–еңЁдҪҝз”ЁдёҠжІЎжңүеҢәеҲ«пјҢAPIиҝҷдәӣйғҪжҳҜдёҖж ·зҡ„гҖӮ

2гҖҒжЁЎејҸз®Җд»Ӣ

MCAL WdgжЁЎеқ—е®ҡд№үдәҶдёүз§ҚжЁЎејҸпјҢе…·дҪ“е®ҡд№үи§ҒдёӢиЎЁпјҡ

жЁЎејҸе®ҡд№ү жЁЎејҸжҸҸиҝ°

| Off Mode |

иҜҘжЁЎејҸдёӢпјҢWdg硬件关й—ӯгҖӮжңүж—¶еҖҷжҲ‘们еҸҜиғҪйңҖиҰҒе°Ҷж•ҙдёӘECUе…ій—ӯпјҢиҖҢдёҚйңҖиҰҒзңӢй—ЁзӢ—жҸҗдҫӣе‘ЁжңҹеӨҚдҪҚеҠҹиғҪпјҢиҝҷз§Қжғ…еҶөдёӢеҸҜдҪҝз”ЁиҜҘжЁЎејҸгҖӮдҪҶеҜ№дәҺдёҖдәӣе®үе…ЁжҖ§иҰҒжұӮеҫҲй«ҳзҡ„зі»з»ҹпјҢйҖҡеёёе…ій—ӯWdgжҳҜдёҚе…Ғи®ёзҡ„пјҢиҝҷз§Қжғ…еҶөдёӢпјҢеҝ…йЎ»й…ҚзҪ®WdgжЁЎеқ—д»ҘйҳІжӯўеҲҮжҚўеҲ°иҜҘжЁЎејҸгҖӮ |

| Slow Mode |

иҜҘжЁЎејҸз”ЁдәҺзӣ‘жҺ§йӮЈдәӣе…·жңүиҫғй•ҝи¶…ж—¶ж—¶й—ҙзҡ„еңәжҷҜпјҢжҜ”еҰӮзі»з»ҹеҗҜеҠЁйҳ¶ж®ө/еҲқе§ӢеҢ–йҳ¶ж®өгҖӮ |

| Fast Mode |

еҜ№дәҺйӮЈдәӣеҝ…йЎ»еңЁеҫҲзҹӯи¶…ж—¶ж—¶й—ҙеҶ…е®ҢжҲҗи§ҰеҸ‘зңӢй—ЁзӢ—еӨҚдҪҚзҡ„еңәжҷҜеҲҷйңҖдҪҝз”ЁжӯӨжЁЎејҸгҖӮжҜ”еҰӮECUжӯЈеёёиҝҗиЎҢжңҹй—ҙгҖӮеҸҲжҲ–иҖ…зңӢй—ЁзӢ—й…ҚзҪ®дёәзӘ—еҸЈжЁЎејҸж—¶пјҲеӣ дёәзӘ—еҸЈжЁЎејҸеҝ…йЎ»еңЁи®ҫзҪ®зҡ„жңҖе°Ҹе’ҢжңҖеӨ§иҫ№з•ҢеҶ…еҺ»и§ҰеҸ‘пјҢйҖҡеёёиҝҷдёӘзӘ—еҸЈжҜ”иҫғзӘ„/ж—¶й—ҙзҹӯпјүгҖӮ |

3гҖҒе®һзҺ°еҺҹзҗҶ

еҶ…йғЁзңӢй—ЁзӢ—жңҚеҠЎзЁӢеәҸеҸҜд»ҘйҖҡиҝҮзӢ¬з«ӢдәҺе…¶д»–еӨ–и®ҫзҡ„еҶ…йғЁзЎ¬д»¶и®Ўж—¶еҷЁпјҲTimerпјүдёӯж–ӯжқҘе®һзҺ°пјҢд№ҹеҸҜд»ҘйҖҡиҝҮGPTй©ұеҠЁжЁЎеқ—зҡ„еӣһи°ғеҮҪж•°жқҘе®һзҺ°гҖӮеҰӮжһңдёҚйҖҡиҝҮGPTе®һзҺ°пјҢиҖҢйҖҡиҝҮдёӯж–ӯпјҲдёҖзұ»/дәҢзұ»дёӯж–ӯпјүе®һзҺ°пјҢеҲҷйңҖиҰҒжҹҘзңӢеҺӮе•ҶжҸҗдҫӣзҡ„ж–ҮжЎЈжҸҸиҝ°пјҢйҖҡеёёе®ғйҒөеҫӘдёҖзұ»/дәҢзұ»дёӯж–ӯзҡ„дҪҝз”ЁжқЎд»¶/жіЁж„ҸдәӢйЎ№гҖӮдҪҶжҳҜдёҚз®Ўе“Әз§Қе®һзҺ°ж–№ејҸпјҢж ҮеҮҶйҮҢйқўе№¶жІЎжңүе…·дҪ“规е®ҡпјҢз”ұз”ЁжҲ·иҮӘиЎҢеҶіе®ҡгҖӮ

еңЁд№ӢеүҚзҡ„зүҲжң¬дёӯпјҢзңӢй—ЁзӢ—жңҚеҠЎдҫӢзЁӢжҳҜз”ұдёҠеұӮиҪҜ件жқҘи°ғз”Ёзҡ„пјҢиҝҷдјҡжңүдёҖдёӘй—®йўҳпјҢе°ұжҳҜеҫҲйҡҫдҝқиҜҒй’ҲеҜ№зӘ—еҸЈејҸзңӢй—ЁзӢ—иҝҷз§ҚдёҘж јзҡ„ж—¶й—ҙзәҰжқҹгҖӮж–°зүҲеҚҸи®®еҜ№иҝҷйғЁеҲҶеҒҡдәҶдјҳеҢ–гҖӮдјҳеҢ–зҡ„еҹәжң¬жҖқжғіжҳҜе°Ҷз”ЁдәҺз»ҙжҠӨзңӢй—ЁзӢ—硬件时еәҸзҡ„жңҚеҠЎдҫӢзЁӢдёҺйҖ»иҫ‘жҺ§еҲ¶еҲҶејҖгҖӮи§ҰеҸ‘зңӢй—ЁзӢ—зҡ„ж—¶еҹәеҸҜд»ҘйҖҡиҝҮ硬件жқҘжҸҗдҫӣпјҢиҝҷж ·еҸҜзЎ®дҝқжңҖе°Ҹзҡ„ж—¶еәҸжҠ–еҠЁгҖӮиҖҢжҺ§еҲ¶зңӢй—ЁзӢ—硬件зҡ„зЁӢеәҸеҸҜзӣҙжҺҘеңЁе®ҡж—¶еҷЁдёӯж–ӯеҮҪж•°йҮҢйқўе®һзҺ°д»ҘзЎ®дҝқжңҖе°Ҹ延иҝҹгҖӮиҝҷдёӨдёӘжқЎд»¶пјҲжңҖе°Ҹж—¶еәҸжҠ–еҠЁгҖҒжңҖе°Ҹ延иҝҹпјүзЎ®дҝқеҸҜд»Ҙж»Ўи¶ізӘ—еҸЈејҸзңӢй—ЁзӢ—зҡ„ж—¶й—ҙзӘ—еҸЈпјҲд№ҹе°ұжҳҜдёҠдёҖж®өжҸҗеҲ°зҡ„е®һзҺ°ж–№жі•пјүгҖӮ

дёәдәҶдҝқжҢҒдёҠеұӮжЁЎеқ—пјҲжҜ”еҰӮWdgM/Wdgз®ЎзҗҶеҷЁпјүзҡ„еҹәжң¬жҰӮеҝөдёҚеҸҳпјҢWdgй©ұеҠЁжЁЎеқ—жңҹжңӣзңӢй—ЁзӢ—зҡ„жҺ§еҲ¶йҖ»иҫ‘пјҲжҳҜеҗҰйңҖиҰҒиў«и§ҰеҸ‘/е–ӮзӢ—пјүз”ұзҺҜеўғзҺҜеўғпјҲWdgMпјүиҙҹиҙЈгҖӮ

жғіжғіжҲ‘们иҮӘе·ұе№іж—¶еҶҷд»Јз ҒзӣҙжҺҘеҺ»ж“ҚдҪңзңӢй—ЁзӢ—硬件еҜ„еӯҳеҷЁпјҢйӮЈд№ҲжҲ‘们жүҖиғҪи®ҫзҪ®зҡ„и§ҰеҸ‘ж—¶й—ҙ/е–ӮзӢ—е°ұе®Ңе…Ёз”ұ硬件еҶіе®ҡдәҶпјҢйҖҡеёёиҝҷдёӘж—¶й—ҙдёҚдјҡеӨӘй•ҝпјҢеҫҲеӨҡиҠҜзүҮеңЁ100msиҝҷз§Қзә§еҲ«гҖӮдҪҶжҳҜж–Үз« дёҖејҖе§ӢиҜҙдәҶWdgжЁЎеқ—жҸҗдҫӣ3з§ҚжЁЎејҸпјҢе…¶дёӯдёӨз§ҚжҳҜSlowпјҢFastжЁЎејҸпјҢеҰӮжһңиҝҷж ·зҡ„иҜқпјҢжҲ‘们зӣҙжҺҘеҺ»ж“ҚдҪң硬件еҜ„еӯҳеҷЁиҝҷз§Қж–№жі•жҳҜдёҚжҳҜе°ұеҫҲйҡҫеӨ„зҗҶдәҶпјҢеӣ дёәи§ҰеҸ‘/е–ӮзӢ—е‘ЁжңҹйғҪжҳҜеӣәе®ҡзҡ„дё”жҜ”иҫғзҹӯпјҢдҪҶеҫҲеӨҡж—¶еҖҷеә”з”ЁеұӮеҸҜиғҪ并дёҚйңҖиҰҒйӮЈд№ҲдёҘж јзҡ„ж—¶й—ҙзӣ‘жҺ§пјҢеҸҜиғҪз§’зә§зҡ„е‘ЁжңҹеҚіеҸҜпјҲжҖ»д№Ӣе°ұжҳҜиҝҷдёӘе‘ЁжңҹеӨ§дәҺзңӢй—ЁзӢ—硬件еҜ„еӯҳеҷЁзҡ„жңҖеӨ§еҖјдәҶпјүпјҢиҝҷз§Қжғ…еҶөжҳҜдёҚжҳҜе°ұйңҖиҰҒеә”з”ЁеұӮдёҚж–ӯеҺ»е–ӮзӢ—пјҢиҝҷеҜ№еә”з”ЁеұӮзҡ„д»Јз Ғе®һзҺ°еҪұе“Қе°ұеҫҲеӨ§дәҶпјҢд»–йңҖиҰҒеҲ°еӨ„з©ҝжҸ’е–ӮзӢ—еҮҪж•°гҖӮжҲ‘жғіеҸҜиғҪиҝҳжңүдёҖдёӘеҫҲйҮҚиҰҒзҡ„еҺҹеӣ пјҢзҺ°еңЁеӨ§е®¶еҜ№еҠҹиғҪе®үе…Ёи¶ҠжқҘи¶ҠйҮҚи§ҶпјҢйӮЈд№ҲеҜ№иҝҷз§Қйў‘з№Ғдҝ®ж”№зңӢй—ЁзӢ—硬件еҜ„еӯҳеҷЁзҡ„ж“ҚдҪңжҳҜдёҚжҺЁиҚҗзҡ„пјҲжң¬иә«д»–зҡ„ж“ҚдҪңжҖ§иғҪе°ұдёҚй«ҳпјҢйҖҡеёёйңҖиҰҒдёҖдёӘеәҸеҲ—жүҚиғҪиҝӣиЎҢдҝ®ж”№пјүгҖӮ

дёәдәҶж–№дҫҝеӨ§е®¶иҝӣдёҖжӯҘзҗҶи§ЈпјҢжҺҘдёӢжқҘжҲ‘е…ҲиҜҙиҜҙжҲ‘еҜ№е®һзҺ°ж–№жі•зҡ„дёҖз§Қжғіжі•гҖӮе…¶е®һе®һзҺ°еҺҹзҗҶд№ҹеҫҲз®ҖеҚ•гҖӮйҰ–е…ҲиҜҙдёҖдёӢSlowпјҢFastдёӨз§ҚжЁЎејҸеҜ№ж—¶й’ҹзҡ„иҰҒжұӮпјҢйҖҡеёёиҝҷдёӨз§ҚжЁЎејҸWdgжүҖдҪҝз”Ёзҡ„еҸӮиҖғж—¶й’ҹдёҚдёҖж ·пјҢSlowжЁЎејҸдҪҝз”Ёзҡ„еҸӮиҖғж—¶й’ҹйў‘зҺҮжҜ”иҫғе°Ҹ/ж…ўпјҢиҖҢFastжЁЎејҸжүҖдҪҝз”Ёзҡ„еҸӮиҖғж—¶й’ҹйў‘зҺҮжҜ”иҫғеӨ§/еҝ«гҖӮиҝҷеә”иҜҘжҜ”иҫғеҘҪзҗҶи§Јеҗ§гҖӮж №жҚ®дёҠдёҖз« иҠӮеҫ—зҹҘпјҢеӣ дёәйҖҡеёёSlowжЁЎејҸз”ЁдәҺйӮЈз§ҚеҜ№и¶…ж—¶ж—¶й—ҙжҜ”иҫғй•ҝзҡ„еңәжҷҜгҖӮеҪ“然дҪ иҜҙжҲ‘е°ұз”ЁеҗҢдёҖдёӘж—¶й’ҹжәҗжҳҜеҗҰеҸҜд»Ҙе‘ўпјҹжҠҖжңҜдёҠеҪ“然жҳҜеҸҜд»Ҙзҡ„гҖӮдҪҶйҖҡеёёйғҪжҳҜжҢүз…§еүҚйқўжҸҸиҝ°жқҘе®һзҺ°гҖӮ

йҷӨдәҶдёҠйқўжҸҗеҲ°зҡ„WdgжЁЎеқ—зҡ„еҸӮиҖғж—¶й’ҹпјҢиҝҳйңҖиҰҒйўқеӨ–зҡ„GPTж—¶й’ҹпјҲжҲ‘们иҝҷйҮҢеӣ дёәдҪҝз”Ёзҡ„GPTеӣһи°ғеҮҪж•°зҡ„е®һзҺ°ж–№ејҸпјүпјҢGPTиҝҷдёӘж—¶й’ҹз”ЁжқҘе№Іеҳӣе‘ўпјҹе®һйҷ…дёҠпјҢзңҹжӯЈе–ӮзӢ—е°ұйқ иҝҷдёӘGPTдәҶпјҲе–ӮзӢ—ж—¶й’ҹпјүпјҢд№ҹе°ұжҳҜиҜҙеә”з”ЁеұӮи°ғз”Ёе–ӮзӢ—еҮҪж•°пјҲWdg_SetTriggerConditionпјү并дёҚжҳҜзӣҙжҺҘеҺ»ж“ҚдҪңзңӢй—ЁзӢ—硬件еҜ„еӯҳеҷЁзҡ„пјҢиҖҢжҳҜеҺ»й…ҚзҪ®GPTпјҢ然еҗҺз”ұGPTдёӯж–ӯеӣһи°ғеҺ»ж“ҚдҪңзңӢй—ЁзӢ—硬件еҜ„еӯҳеҷЁгҖӮ

е…·дҪ“жөҒзЁӢжҳҜиҝҷж ·зҡ„пјҡеңЁи°ғз”ЁеҲқе§ӢеҢ–еҮҪж•°зҡ„ж—¶еҖҷпјҢеҲқе§ӢеҢ–еҮҪж•°дјҡиҮӘеҠЁж №жҚ®дҪ й…ҚзҪ®зҡ„жЁЎејҸгҖҒеҜ№еә”жЁЎејҸзҡ„еҸӮиҖғж—¶й’ҹжәҗйў‘зҺҮд»ҘеҸҠе–ӮзӢ—ж—¶й’ҹжәҗйў‘зҺҮжқҘи®Ўз®—е–ӮзӢ—ж—¶й’ҹзҡ„дёӯж–ӯе‘ЁжңҹпјҲдёәиҝһз»ӯжЁЎејҸпјҢиҖҢйқһдёҖж¬ЎжҖ§жЁЎејҸпјүпјҢеҰӮжһңдёәзӘ—еҸЈејҸзңӢй—ЁзӢ—пјҢеҲҷGPTзҡ„е‘ЁжңҹдёәзӘ—еҸЈзҡ„дёӯй—ҙзӮ№пјӣеҰӮжһңдёәйқһзӘ—еҸЈејҸпјҢеҲҷе‘ЁжңҹзӯүдәҺзңӢй—ЁзӢ—и¶…ж—¶ж—¶й—ҙпјҲиҝҷйҮҢз»ҶиҠӮдёҠзҡ„дёңиҘҝжҜ”иҫғеӨҡпјҢе°ұдёҚдёҖдёҖи®Іи§ЈдәҶпјҢжҜ”еҰӮз”ұдәҺиҝҗз®—еҜјиҮҙзҡ„е°Ҹж•°еӨ„зҗҶзӯүгҖӮжҖ»д№ӢпјҢGPTзҡ„е‘Ёжңҹдёӯж–ӯйңҖдҝқиҜҒе°ҸдәҺWdg硬件超时时й—ҙпјҢжҲ–иҖ…GPTдёӯж–ӯдјҳе…Ҳзә§й«ҳдәҺWdgзҡ„дёӯж–ӯдјҳе…Ҳзә§пјүгҖӮ然еҗҺеҗҜеҠЁиҜҘGPTејҖе§Ӣи®Ўж—¶пјҢWdgд№ҹејҖе§Ӣи®Ўж—¶пјҲжіЁж„ҸпјҢиҝҷйҮҢ他们еҗ„иҮӘжңүеҗ„иҮӘзҡ„и®Ўж—¶еҷЁпјүгҖӮGPTдёӯж–ӯеҸ‘з”ҹеҗҺи°ғз”ЁGPTеҜ№еә”зҡ„еӣһи°ғеҮҪж•°пјҢGPTеӣһи°ғеҮҪж•°и°ғз”ЁWdgжЁЎеқ—зӣёе…ізҡ„е–ӮзӢ—еҮҪж•°пјҲиҝҷйҮҢжүҚжҳҜзңҹжӯЈеҺ»ж“ҚдҪңзңӢй—ЁзӢ—硬件еҜ„еӯҳеҷЁиҝӣиЎҢе–ӮзӢ—зҡ„пјүгҖӮ

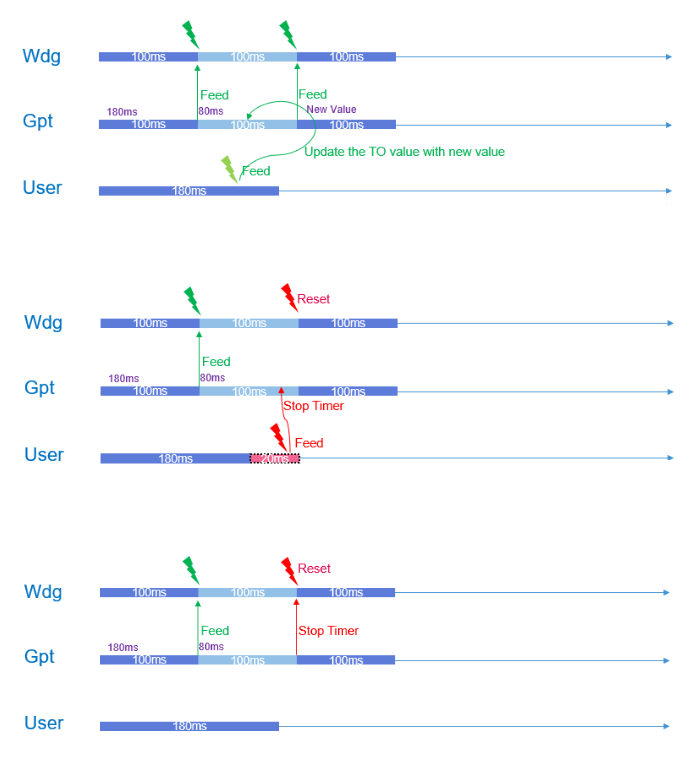

дёҫдёӘдҫӢеӯҗпјҢеҒҮеҰӮWdgзҡ„и¶…ж—¶ж—¶й—ҙжҳҜ100msгҖӮжҲ‘们иҝҷйҮҢе°ұи®Іжҷ®йҖҡпјҲToggleпјүжЁЎејҸе“Ҳ,зӘ—еҸЈжЁЎејҸеӨ„зҗҶжҖқи·ҜдёҖж ·пјҢеҸӘжҳҜз»ҶиҠӮдёҠжңүе·®еҲ«гҖӮзҺ°еңЁз”ЁжҲ·еңЁ0ж—¶еҲ»и®ҫзҪ®дәҶи¶…ж—¶ж—¶й—ҙжҳҜ180msпјҲ0ж—¶еҲ»е…¶е®һеә”иҜҘжҳҜеҲқе§ӢеҢ–е®ҢжҲҗзҡ„пјҢдёәдәҶеҘҪзҗҶи§ЈпјҢжҲ‘们еҒҮи®ҫз”ЁжҲ·и°ғз”ЁдәҶе–ӮзӢ—еҮҪж•°пјүпјҢзЁӢеәҸдјҡи®°еҪ•иҝҷдёӘ180msи¶…ж—¶ж—¶й—ҙпјҢдҪ дјҡеҸ‘зҺ°з”ЁжҲ·и®ҫзҪ®зҡ„е·Із»ҸеӨ§дәҺWdgзҡ„и¶…ж—¶ж—¶й—ҙдәҶпјҢеҪ“100msеҲ°иҫҫж—¶пјҢGPTдёӯж–ӯдә§з”ҹдәҶпјҢеҸ‘зҺ°з”ЁжҲ·и®°еҪ•зҡ„и¶…ж—¶ж—¶й—ҙпјҲ180msпјүиҝҳжІЎеҲ°пјҢдәҺжҳҜдё»еҠЁеҺ»е–ӮзӢ—дәҶпјҲдёҚйңҖиҰҒз”ЁжҲ·и°ғз”Ёе–ӮзӢ—еҮҪж•°пјүпјҢеҗҢж—¶дјҡе°Ҷд№ӢеүҚи®°еҪ•зҡ„180msи¶…ж—¶ж—¶й—ҙеҮҸеҺ»100msпјҢеҸҳжҲҗ80msпјҢеҮҸеҺ»зҡ„100msжӯЈејҸе·Із»ҸиҠұжҺүзҡ„ж—¶й—ҙпјҢ然еҗҺ继з»ӯиҝҗиЎҢгҖӮ

еңЁдёӢдёҖж¬Ў100msеҲ°иҫҫеүҚе°ұжңүдёүз§Қжғ…еҶөдәҶпјҢдёҖз§ҚжҳҜз”ЁжҲ·еңЁ80msд№ӢеүҚи°ғз”ЁдәҶе–ӮзӢ—еҮҪж•°жқҘжӣҙж–°гҖӮ第дәҢз§Қжғ…еҶөжҳҜз”ЁжҲ·д№ҹе–ӮзӢ—дәҶпјҢдҪҶжҳҜи°ғз”ЁеҮҪж•°зҡ„ж—¶й—ҙжҳҜеңЁ80msд№ӢеҗҺпјҢ100msд№ӢеүҚгҖӮиҝҳжңүдёҖз§Қе°ұжҳҜ100msдёӯж–ӯеҸ‘з”ҹдәҶйғҪиҝҳжІЎжңүи°ғз”Ёе–ӮзӢ—еҮҪж•°гҖӮ

й’ҲеҜ№з¬¬дёҖз§Қжғ…еҶөпјҢеҪ“еҶҚж¬Ўи°ғз”Ёе–ӮзӢ—еҮҪж•°ж—¶пјҢзЁӢеәҸдјҡи®Ўз®—дёҠдёҖж¬Ўдёӯж–ӯеҸ‘з”ҹеҲ°жӯӨеҲ»зҡ„ж—¶й—ҙй—ҙйҡ”пјҲд№ҹе°ұжҳҜиҠұжҺүзҡ„ж—¶й—ҙпјүпјҢжҲ‘们иҝҷйҮҢиҝҷдёӘж—¶й—ҙжҳҜе°ҸдәҺ80msзҡ„пјҢиҜҙжҳҺзЁӢеәҸиҝҗиЎҢжҳҜжӯЈеёёзҡ„пјҢз”ЁжҲ·жҢүз…§зәҰе®ҡжқҘе–ӮзӢ—пјҢдәҺжҳҜзЁӢеәҸд»Ҙж–°дј е…Ҙзҡ„и¶…ж—¶ж—¶й—ҙйҮҚж–°и®Ўз®—дёҖдёӘи¶…ж—¶ж—¶й—ҙжӣҙж–°д№ӢеүҚи®°еҪ•зҡ„и¶…ж—¶ж—¶й—ҙпјҲеҪ“然пјҢжӯЈеёёжғ…еҶөдёӢпјҢиҝҷдёӘж–°зҡ„еҖјдјҡеӨ§дәҺ100msпјҢеҰӮжһңе°ҸдәҺ100msпјҢйӮЈе°ұе’ҢеҗҺйқўеҮ з§Қжғ…еҶөеӨ„зҗҶдёҖж ·дәҶпјҢиҝҷйҮҢжҸҗйҮҚж–°и®Ўз®—иҖҢжІЎжңүиҜҙзӣҙжҺҘиҰҶзӣ–пјҢжҳҜз”ұдәҺйҮҢйқўдјҡжңүдёҖдәӣж—¶й—ҙиЎҘеҒҝпјүпјҢ然еҗҺ继з»ӯжӯЈеёёиҝҗиЎҢгҖӮ

第дәҢз§Қжғ…еҶөе…¶е®һе°ұжҳҜеүҚйқўз¬¬дёҖз§Қжғ…еҶөйҮҢйқўжҸҗзҡ„йӮЈдёӘй—ҙйҡ”ж—¶й—ҙдјҡеӨ§дәҺ80msпјҲеҒҮеҰӮз”ЁжҲ·жҳҜеңЁ90msиҝҷдёӘж—¶й—ҙи°ғз”Ёзҡ„еҮҪж•°пјүпјҢеҲӨж–ӯеӨ§дәҺеҗҺпјҢиҷҪ然用жҲ·еңЁ100msдёӯж–ӯеүҚи°ғз”ЁдәҶпјҢдҪҶжҳҜиҝҳжҳҜжІЎжңүжҢүз…§з”ЁжҲ·иҮӘе·ұиҜҙзҡ„180msжқҘе–ӮзӢ—пјҲеҠ дёҠ第дёҖж¬Ўзҡ„зҡ„100msдёӯж–ӯж—¶й—ҙпјҢз”ЁжҲ·жҳҜеңЁ190msжүҚе–ӮзӢ—пјүпјҢз”ЁжҲ·иҝҳжҳҜиҝқзәҰдәҶпјҢжүҖд»ҘзЁӢеәҸз«Ӣ马еҒңжҺүGPT TimerгҖӮеҪ“第дәҢдёӘ100msеҲ°еҗҺпјҢиҝҷж—¶Wdgзҡ„и¶…ж—¶ж—¶й—ҙеҲ°дәҶпјҢдҪҶжҳҜз”ұдәҺGPTе·Із»ҸеҒңжҺүпјҢдёҚдјҡдә§з”ҹдёӯж–ӯеҺ»е–ӮзӢ—пјҢдәҺжҳҜWdgе°ұеӨҚдҪҚECUпјҲдёҘж јжқҘиҜҙпјҢиҝҷйҮҢзҡ„иЎҢдёәдёҺз”ЁжҲ·й…ҚзҪ®жңүе…іпјҢеҸҜиғҪжҳҜзӣҙжҺҘеӨҚдҪҚECUпјҢд№ҹеҸҜиғҪжҳҜдә§з”ҹдёӯж–ӯзӯүзӯүпјүгҖӮ

第дёүз§Қжғ…еҶөе’Ң第дәҢз§Қзұ»дјјпјҢеҢәеҲ«еңЁдәҺ100msеҲ°иҫҫеҗҺпјҢGPTзҡ„дёӯж–ӯиҝҳжҳҜдјҡдә§з”ҹпјҢ然еҗҺеңЁдёӯж–ӯеӣһи°ғйҮҢйқўеҺ»еҲӨж–ӯи®°еҪ•зҡ„и¶…ж—¶ж—¶й—ҙ80msе°ҸдәҺдәҶдёӯж–ӯзҡ„е‘Ёжңҹж—¶й—ҙ100msпјҢдәҺжҳҜз«Ӣ马еҒңжҺүGPT TimerпјҢдёҚе–ӮзӢ—гҖӮжҺҘдёӢжқҘWdgд№ҹз«Ӣ马еҸ‘зҺ°ж—¶й—ҙеҲ°дәҶпјҢдәҺжҳҜеӨҚдҪҚECUгҖӮ

зңӢеҮәжқҘжІЎжңүпјҢиҝҷе°ұжҳҜдёәдҪ•еүҚйқўиҜҙGPTзҡ„е‘Ёжңҹе°ҸдәҺWdgзҡ„и¶…ж—¶ж—¶й—ҙ/дёӯж–ӯдјҳе…Ҳзә§й«ҳзҡ„еҺҹеӣ гҖӮеҰӮжһңд»–еӨ§дәҺWdgзҡ„и¶…ж—¶ж—¶й—ҙпјҢйӮЈд№Ҳд»–ж №жң¬жІЎжңүеҠһжі•иҮӘдё»е–ӮзӢ—дәҶпјҢд№ҹжІЎеҠһжі•еңЁз¬¬дёүз§Қжғ…еҶөз«ӢеҚіеҒңжҺүTimerгҖӮеҗҢж—¶ECUеӨҚдҪҚзҡ„ж—¶й—ҙе…¶е®һд№ҹжҳҜжңү延时зҡ„пјҢе…·дҪ“延时时й—ҙдёҺдёҚеҗҢж—¶й—ҙз»„еҗҲжңүеҫҲеӨ§е…ізі»гҖӮ

и®ІеҲ°иҝҷйҮҢеә”иҜҘе·Із»ҸжҳҺзҷҪдәҶе®ғзҡ„еҹәжң¬е·ҘдҪңеҺҹзҗҶдәҶгҖӮеҪ“然йҮҢйқўж¶үеҸҠеҲ°еҫҲеӨҡз»ҶиҠӮе°ұж— жі•дёҖдёҖеұ•ејҖдәҶпјҢжҜ”еҰӮжЁЎејҸеҲҮжҚўзҡ„еӨ„зҗҶпјҢеҲқе§ӢеҢ–е’ҢиҝҗиЎҢжңҹй—ҙзӢ¬з«Ӣзҡ„и¶…ж—¶й…ҚзҪ®зӯүзӯүгҖӮ

жӣҙзӣҙи§ӮдёҖзӮ№пјҢдёӢеӣҫжҸҸиҝ°дәҶдёҠйқўзҡ„еҶ…е®№пјҡ

д»ҘдёҠеҶ…е®№жҳҜжҲ‘зҡ„дёҖдәӣжғіжі•пјҢеҸҜиғҪжңүдәӣең°ж–№иҝҳдёҚеӨӘе®Ңе–„пјҢдҪҶеӨ§дҪ“дёҠеә”иҜҘжІЎй—®йўҳгҖӮ

**е°ҸжҸ’жӣІпјҡ**е®һйҷ…дёҠд»ҘдёҠзҡ„еҶ…е®№жңҖејҖе§ӢжҳҜжҲ‘еҲҶжһҗNXPзҡ„д»Јз Ғеҫ—еҲ°зҡ„з»“и®әпјҢдҪҶеҗҺйқўеҸ‘зҺ°жҲ‘еҝҪз•ҘдәҶе…¶д»Јз Ғзҡ„дёҖдёӘеҫҲз»ҶиҠӮзҡ„ең°ж–№пјҢжҠҠNXPзҡ„д»Јз ҒзҗҶи§Јй”ҷдәҶпјҢжӣҙжүҜзҡ„жҳҜпјҢз»ҸиҝҮд»”з»ҶеҜ№жҜ”еҗҺеҸ‘зҺ°жҲ‘зҡ„зҗҶи§Јжңүдәӣең°ж–№еҸҚиҖҢжӣҙжңүдјҳеҠҝпјҢзҙўжҖ§е°ұеҸҳжҲҗиҮӘе·ұзҡ„жғіжі•дәҶрҹҳ„гҖӮжҜ”еҰӮз”ЁжҲ·и®ҫзҪ®зҡ„и¶…ж—¶ж—¶й—ҙеҸҜд»ҘдёҚеҸ—Wdgзҡ„жңҖеӨ§ж—¶й—ҙйҷҗеҲ¶гҖӮдҪҶд№ҹжңүдёҖдәӣең°ж–№е®һзҺ°иө·жқҘеҸҜиғҪжҜ”иҫғйә»зғҰпјҢжҜ”еҰӮGPTе’ҢWdgзҡ„TimerдёҠйқўиҜҙзҡ„жҳҜеҗҢж—¶ејҖеҗҜпјҢиҝҷдёӘеҗҢжӯҘеҸҜиғҪжҜ”иҫғйә»зғҰгҖӮе°ұз®—еҰӮжӯӨпјҢд№ҹеҸҜд»ҘеңЁGPTдёӯж–ӯйӮЈйҮҢзЁҚеҫ®еӨ„зҗҶдёҖдёӢпјҢжҜ”еҰӮйҖӮеҪ“еҮҸеҺ»дёҖзӮ№ж—¶й—ҙгҖӮеҪ“然зӣёжҜ”дәҺNXPзҡ„д»Јз Ғд№ҹжңүеҠЈеҠҝпјҲиҝҷйҮҢжҢҮжӯЈзЎ®зҗҶи§ЈеҗҺпјҢи§ҒдёӢж–ҮпјүпјҢжҲ‘зҗҶи§Јзҡ„ж–№жі•зңӢй—ЁзӢ—еӨҚдҪҚзҡ„иҜҜе·®еҸҜиғҪжӣҙеӨ§гҖӮж¬ўиҝҺеӨ§е®¶и®Ёи®әгҖӮзңӢзңӢжңүжІЎжңүе…¶д»–дёҚеҰҘгҖӮ

зҺ°еңЁеҶҚжқҘиҜҙиҜҙNXPзҡ„д»Јз Ғе®һзҺ°ж–№ејҸеҲ°еә•жҳҜжҖҺд№Ҳж ·зҡ„гҖӮеҶҚж¬Ўејәи°ғдёҖдёӢпјҢдёҚеҗҢеҺӮ家е®һзҺ°ж–№ејҸеҸҜиғҪдёҚдёҖж ·гҖӮNXPзҡ„д»Јз ҒжҳҜеҹәдәҺGPTеӣһи°ғеҮҪж•°зҡ„ж–№ејҸе®һзҺ°зҡ„пјҢе’ҢжҲ‘дёҠйқўжҸҸиҝ°зҡ„е·®еҲ«еңЁдәҺпјҡ

Wdgзҡ„и¶…ж—¶ж—¶й—ҙе°ұжҳҜз”ЁжҲ·й…ҚзҪ®зҡ„и¶…ж—¶ж—¶й—ҙпјҢGPTе‘Ёжңҹдёӯж–ӯзҡ„ж—¶й—ҙзӯүдәҺз”ЁжҲ·й…ҚзҪ®зҡ„и¶…ж—¶ж—¶й—ҙзҡ„дәҢеҲҶд№ӢдёҖгҖӮиҝҷдёӨиҖ…йғҪжҳҜеҲқе§ӢеҢ–е°ұеӣәе®ҡеҘҪпјҢеҗҺйқўдёҚдјҡжӣҙж”№зҡ„гҖӮд»Җд№Ҳж„ҸжҖқе‘ўпјҢд№ҹе°ұжҳҜиҜҙз”ЁжҲ·й…ҚзҪ®зҡ„и¶…ж—¶ж—¶й—ҙеҸ—Wdgзҡ„жңҖеӨ§ж—¶й—ҙйҷҗеҲ¶пјҢдҪ дёҚиғҪй…ҚзҪ®еӨӘй•ҝдәҶгҖӮиҝҷдёҖзӮ№е’ҢжҲ‘зҡ„жғіжі•жңүеҢәеҲ«пјҢжҲ‘зҡ„жғіжі•еҸӘжҳҜGPTдёӯж–ӯеңЁWdgд№ӢеүҚе°ұеҸҜд»ҘдәҶпјҢеҜ№з”ЁжҲ·жІЎйҷҗеҲ¶гҖӮиҮідәҺGPTзҡ„ж—¶й—ҙдёәдҪ•жҳҜдәҢеҲҶд№ӢдёҖпјҢжҲ‘жғіжҳҜеӣ дёәжҲ‘дёҠйқўжҸҗеҲ°зҡ„еҗҢжӯҘеҺҹеӣ пјҢеҠ дёҠйҮҮж ·е®ҡзҗҶпјҢжүҖд»Ҙй…ҚзҪ®дәҶдәҢеҲҶд№ӢдёҖпјҢеҰӮжһңй…Қзҡ„жӣҙзҹӯпјҢзҗҶи®әдёҠжҳҜеҸҜд»Ҙзҡ„пјҢдҪҶжҳҜдјҡеҠ йҮҚзі»з»ҹиҙҹжӢ…пјҲдёӯж–ӯжӣҙеӨҡпјүгҖӮе…¶д»–ең°ж–№зҡ„жҖқи·ҜйғҪжҳҜдёҖж ·зҡ„пјҢжҜ•з«ҹеҺҹжң¬жҲ‘еҫ—жғіжі•жқҘжәҗдәҺNXPзҡ„д»Јз ҒгҖӮ

еҲҶжһҗдёӢжқҘпјҢеҰӮжһңжҲ‘们дёҚиҖғиҷ‘еҠҹиғҪе®үе…ЁпјҢеҚ•д»ҺеҠҹиғҪдёҠжқҘзңӢпјҢNXPзҡ„д»Јз Ғе…¶е®һе’ҢжҲ‘们зӣҙжҺҘеҺ»ж“ҚдҪңзңӢй—ЁзӢ—еҜ„еӯҳеҷЁзҡ„ж–№жі•жІЎжңүдјҳеҠҝпјҢеҸҚиҖҢеӨҡз”ЁдәҶGPTзҡ„иө„жәҗд»ҘеҸҠеӨҚжқӮзҡ„еӨ„зҗҶйҖ»иҫ‘гҖӮжҲ‘зҡ„ж–№жі•еңЁеҜ№еә”з”ЁеұӮй…ҚзҪ®зҡ„и¶…ж—¶ж—¶й—ҙиҝӣиЎҢдәҶжү©еұ•пјҢдёҚеҸ—Wdgзҡ„йҷҗеҲ¶гҖӮ

|