|

ç›®ه½•

ه¯¹è±،è·ںè¸ھو¶و„

ç›®çڑ„/用ن¾‹

وœ¬و–‡و،£ه®ڑن¹‰ن؛†ه¯¹è±،è·ںè¸ھه™¨éپµه¾ھçڑ„é«کç؛§و¶و„م€‚

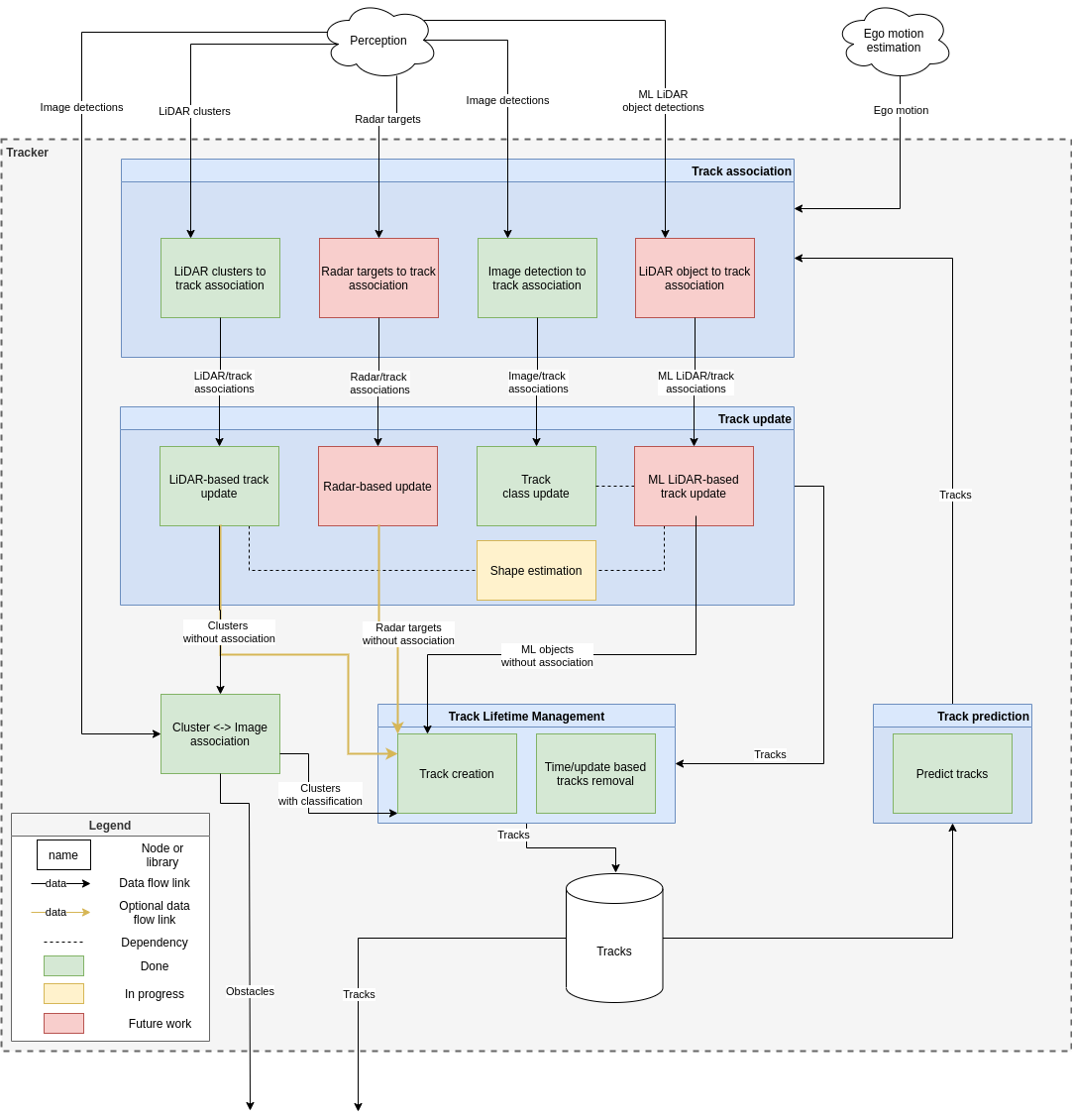

و¶و„

该系ç»ں设è®،背هگژçڑ„و ¸ه؟ƒو€وƒ³وک¯وˆ‘ن»¬ه¸Œوœ›هœ¨è·ںè¸ھç®،éپ“ن¸ن½؟用ه¤ڑن¸ھ输ه…¥م€‚ é€ڑه¸¸ن¹ںه¾ˆéڑ¾هگŒو¥ن¸چهگŒçڑ„输ه…¥م€‚ 该و¶و„ن»¥è؟™ن¸¤ن¸ھهپ‡è®¾ن¸؛وŒ‡ه¯¼ï¼ڑه®ƒه…پ许هœ¨و¯ڈو،و¶ˆوپ¯هڈ¯ç”¨و—¶ه°½و—©ه¤„çگ†ه®ƒï¼ŒهگŒو—¶ن»چ然ن½؟用ه…¶ن»–ن¼ ه…¥و¶ˆوپ¯م€‚

è¦ه‘ٹ ç”±ن؛ژç›®ه‰چ Autoware.Auto ن¸و¶ˆوپ¯çڑ„设è®،و–¹ه¼ڈ,وˆ‘ن»¬ه°† DetectedObjects و¶ˆوپ¯ç”¨ن؛ژ集群ه’Œوœ؛ه™¨ه¦ن¹ LiDAR 输ه…¥م€‚ è؟™ن¸چه؛”该وک¯è؟™و ·م€‚ èپڑç±»ه؛”该输ه‡؛ن¸€ن¸ھو— ه½¢çڑ„点(ه‡¸هŒ…هœ¨è؟™é‡Œن¼¼ن¹ژوک¯ن¸€ن¸ھه¾ˆه¥½çڑ„وٹکè،·ï¼‰ï¼Œè€Œ DetectedObjects و¶ˆوپ¯ه؛”该وœ‰ن¸€ن¸ھوکژç،®çڑ„ه½¢çٹ¶ï¼Œو¯”ه¦‚ن¸€ن¸ھç›’هگوˆ–ن¸€ن¸ھهœ†وں±ن½“م€‚ è؟™ه°†ه…پ许è·ںè¸ھه¯¹è±،çڑ„ه½¢çٹ¶ه¹¶هˆ©ç”¨è؟™ن؛›ç±»ه‹çڑ„ه…¶ن»–ه·®ه¼‚م€‚ è؟™è؟کو²،وœ‰ه®çژ°م€‚

ه·¥ن½œوµپ程

è·ںè¸ھه™¨çڑ„هں؛وœ¬و“چن½œه¦‚ن¸‹ï¼ڑ

- ه°†ن¸چهگŒçڑ„و„ںçں¥è¾“ه…¥ن¸ژçژ°وœ‰è½¨è؟¹ç›¸ه…³èپ”

- و¯ڈن¸ھ输ه…¥éƒ½è¢«è½¬وچ¢وˆگن¸€ن¸ھه…±هگŒçڑ„هڈ‚考系

- 轨è؟¹è¢«é¢„وµ‹هˆ°è¾“ه…¥ه¯¹ه؛”çڑ„و—¶é—´وˆ³

- و¯ڈن¸ھ输ه…¥هڈ¯ن»¥ن½؟用ن¸چهگŒçڑ„ه…³èپ”و–¹و³•

- و›´و–°و›²ç›®

- و¯ڈن¸ھو„ںçں¥è¾“ه…¥هڈ¯ن»¥ن¸؛轨è؟¹è´،献ن¸چهگŒçڑ„ن؟،وپ¯

- ن¾‹ه¦‚,LiDAR 集群وڈگن¾›è½¨éپ“ن½چç½®م€پو–¹هگ‘ه’Œه°؛ه¯¸و›´و–°

- ه›¾هƒڈو£€وµ‹وڈگن¾›è½¨è؟¹هˆ†ç±»و›´و–°

- 轨éپ“è؟گهٹ¨ه¦و›´و–°ç”±ن½؟用وپ’ه®ڑهٹ é€ںه؛¦è؟گهٹ¨و¨،ه‹çڑ„ EKF و‰§è،Œم€‚ 轨éپ“çڑ„هˆ†ç±»çٹ¶و€پن¹ںن½؟用ن¸“é—¨çڑ„ EKF è؟‡و»¤

- هˆ›ه»؛و–°و›²ç›®

- ن¸ژن»»ن½•çژ°وœ‰è½¨éپ“و— ه…³çڑ„و‰€وœ‰è¾“ه…¥éƒ½ه°†هڈ‘é€پهˆ°è½¨éپ“هˆ›ه»؛و¨،ه—

- و ¹وچ®é…چç½®çڑ„轨éپ“هˆ›ه»؛ç–略,و–°è½¨éپ“被هˆ›ه»؛ه¹¶ن¸”ن»چ然وœھن½؟用çڑ„输ه…¥è¢«هڈ‘ه¸ƒن¸؛“éڑœç¢چâ€ï¼ˆن¸چوک¯è½¨éپ“)

- ن¸€ç§چهڈ¯èƒ½çڑ„轨è؟¹هˆ›ه»؛ç–ç•¥وک¯ن»ژه…·وœ‰ç›¸ه؛”ه›¾هƒڈو£€وµ‹ه…³èپ”çڑ„و¯ڈن¸ھ LiDAR 集群هˆ›ه»؛轨è؟¹م€‚ ه›¾هƒڈو£€وµ‹é€ڑه¸¸ن¸چ用ن؛ژهˆ›ه»؛轨è؟¹ï¼Œه› ن¸؛ن»…ن»ژه›¾هƒڈو£€وµ‹و— و³•هڈ¯é هœ°ن¼°è®، 3d ن½چç½®ه’Œو–¹هگ‘

- ن؟®ه‰ھن¸€و®µو—¶é—´وœھو”¶هˆ°و›´و–°çڑ„و›²ç›®

هگو¨،ه—说وکژ

وœ¬èٹ‚ه°†ه¯¹ن¸ٹè؟°ه·¥ن½œوµپ程ن¸وڈگهˆ°çڑ„و¯ڈن¸ھهگو¨،ه—è؟›è،Œé«کç؛§و¦‚è؟°م€‚ وœ‰ه…³و›´è¯¦ç»†çڑ„وڈڈè؟°ï¼Œè¯·هڈ‚éک…特ه®ڑن؛ژهگو¨،ه—çڑ„设è®،و–‡و،£م€‚ ن¸؛و¯ڈن¸ھهگو¨،ه—وڈڈè؟°çڑ„هٹں能هڈ¯èƒ½ه°ڑوœھه®çژ°م€‚ è؟™ه……ه½“ن؛†وŒ‡è·¯وکژçپ¯م€‚ ه…³èپ”

用ن؛ژè·ںè¸ھه…³èپ”çڑ„ LiDAR 集群

Mahalanobis è·ç¦»ç”¨ن؛ژè®،ç®—و¯ڈن¸ھ轨è؟¹ه’Œو£€وµ‹ن¹‹é—´çڑ„ه¯¹ه؛”هˆ†و•°م€‚

هں؛ن؛ژé¢ç§¯ه’Œو¬§ه¼ڈè·ç¦»çڑ„é—¨وژ§وک¯ن¸؛ن؛†ه‡ڈه°‘ه؟…é،»è®،ç®—هˆ†و•°çڑ„هڈ¯èƒ½è½¨è؟¹و£€وµ‹ه¯¹çڑ„و•°é‡ڈم€‚

ن¸€و—¦è®،ç®—ه‡؛هˆ†و•°ï¼Œهˆ†é…چه°†é€ڑè؟‡هŒˆç‰™هˆ©ç®—و³•è؟›è،Œم€‚ 该算و³•è¢«ن؟®و”¹ï¼Œن»¥ن¾؟ه®ƒهڈ¯ن»¥ه¤„çگ†و¯ڈن¸ھو£€وµ‹è½¨éپ“ه¯¹هڈ¯èƒ½و²،وœ‰وœ‰و•ˆهˆ†و•°çڑ„وƒ…ه†µم€‚ 设è®،و–‡و،£

ن¸çڑ„و›´ه¤ڑ详细ن؟،وپ¯

è·ںè¸ھه…³èپ”çڑ„ه›¾هƒڈو£€وµ‹

轨è؟¹è¢«وٹ•ه½±هˆ°ه›¾هƒڈه¹³é¢ن¸ٹم€‚

IOU用ن½œtrackه’Œdetectionن¹‹é—´çڑ„ه¯¹ه؛”هˆ†و•°م€‚ 设è®،و–‡و،£

ن¸çڑ„و›´ه¤ڑ详细ن؟،وپ¯ 视觉 - و؟€ه…‰é›·è¾¾é›†ç¾¤èچهگˆ

وœ¬èٹ‚解é‡ٹن؛†ن¸؛ن»€ن¹ˆوˆ‘ن»¬وœ‰ن¸¤ن¸ھن¸چهگŒçڑ„ه—(هچ³ï¼Œè·ںè¸ھه…³èپ”çڑ„ه›¾هƒڈو£€وµ‹ه’Œé›†ç¾¤ <--> ه›¾هƒڈه…³èپ”)而ن¸چوک¯هڈھوœ‰ن¸€ن¸ھه—(集群 <--> ه›¾هƒڈه…³èپ”)

هپ‡è®¾ï¼ڑ

ن¸€èˆ¬و¥è¯´ï¼Œè§†è§‰و£€وµ‹çڑ„频çژ‡ن½ژن؛ژ LiDAR 集群

LiDAR 集群é€ڑه¸¸ن»¥ 10Hz هڈ‘ه¸ƒم€‚ و¥è‡ھçژ¯ç»•و‘„هƒڈوœ؛çڑ„视觉و£€وµ‹é€ڑه¸¸ن»¥è¾ƒن½ژçڑ„é€ںه؛¦هڈ‘ه¸ƒم€‚

هژںه› ï¼ڑ

هں؛ن؛ژهپ‡è®¾ï¼Œوˆ‘ن»¬ن¸چن¼ڑ让 LiDAR 集群ه’Œè§†è§‰و£€وµ‹هœ¨ç›¸هگŒçڑ„ç،®هˆ‡و—¶é—´وں¥çœ‹ç›¸هگŒçڑ„ç،®هˆ‡ه¯¹è±،م€‚

轨éپ“ه…·وœ‰çٹ¶و€پن؟،وپ¯ï¼Œهڈ¯ن»¥و›´ه®¹وک“هœ°é¢„وµ‹è½¨éپ“هœ¨ن»»ن½•ç»™ه®ڑو—¶é—´وˆ³çڑ„ن½چç½®م€‚ è؟™ن½؟ه¾—ه°†è½¨è؟¹ن¸ژ视觉و£€وµ‹ç›¸ه…³èپ”هڈکه¾—و›´ه®¹وک“م€پو›´ه‡†ç،®م€‚

ن½†ه¹¶éو‰€وœ‰è½¨éپ“都هڈ¯ن»¥ن¸ژ视觉و£€وµ‹ç›¸ه…³èپ”م€‚ ه¯¹ن؛ژهˆڑهˆڑè؟›ه…¥è§†é‡ژçڑ„و–°ç‰©ن½“ه°¤ه…¶ه¦‚و¤م€‚

è؟™و„ڈه‘³ç€وˆ‘ن»¬ن¸چ能ه؟½ç•¥ن¸چ相ه…³çڑ„视觉و£€وµ‹م€‚ ن½؟用ه®ƒن»¬çڑ„وœ€ن½³و–¹و³•وک¯ه°†ه®ƒن»¬ن¸ژ LiDAR 集群相ه…³èپ”م€‚

و؟€ه…‰é›·è¾¾é›†ç¾¤ن¸چن¼ڑهƒڈ视觉و£€وµ‹é‚£و ·و¥è‡ھç،®هˆ‡çڑ„و—¶é—´وˆ³ï¼Œن½†وˆ‘ن»¬هڈ¯ن»¥ه¢هٹ ه…³èپ”çڑ„ه®¹ه·®م€‚ ن¸ژن»…ن½؟用 LiDAR 集群相و¯”,è؟™ن½؟وˆ‘ن»¬èƒ½ه¤ںهœ¨و›´é•؟çڑ„范ه›´ه†…هˆ›ه»؛ه‡†ç،®ن¸”稳ه®ڑçڑ„轨éپ“م€‚

ن½؟用 SVL ن»؟çœںه™¨è؟گè،Œه¤ڑç›®و ‡è·ںè¸ھه™¨

设置ن»؟çœںه™¨

autoware ن¸çڑ„ه¯¹è±،è·ںè¸ھه™¨و—¨هœ¨è®¢éک…هں؛ن؛ژو؟€ه…‰é›·è¾¾é›†ç¾¤çڑ„ه¯¹è±،ه’Œو¥è‡ھ视觉çڑ„ 2d و£€وµ‹م€‚ è¦پ设置ن»؟çœںه™¨و¥و‰§è،Œو¤و“چن½œï¼Œè¯·و›´و”¹è½¦è¾†çڑ„ن¼ و„ںه™¨é…چç½®م€‚ 转هˆ°â€œه؛“â€ه›¾و ‡ن¸‹çڑ„“车辆â€é،µé¢ï¼Œé€‰و‹©و‰€éœ€çڑ„车辆ه¹¶هچ•ه‡»ه…¶ن¸ٹçڑ„“ن¼ و„ںه™¨é…چç½®â€éƒ¨هˆ†ه›¾و ‡م€‚ هچ•ه‡»é،µé¢ه؛•éƒ¨çڑ„“هˆ›ه»؛و–°é…چç½®â€وŒ‰é’®م€‚ 设置é…چç½®هگچ称ه¹¶é€‰و‹©â€œROS2ForUnitySVLBridgeâ€ن½œن¸؛و،¥وژ¥ه™¨م€‚ هچ•ه‡» Visual Editor çھ—هڈ£é™„è؟‘çڑ„“{...}â€ç¬¦هڈ·م€‚ ه°†و¤ه¤„ çڑ„ه†…ه®¹ه¤چهˆ¶ه¹¶ç²کè´´ هˆ°و،†ن¸م€‚ هˆ›ه»؛ن¸€ن¸ھن½؟用è؟™è¾†و”¹è£…车辆ه’Œو‚¨é€‰و‹©çڑ„هœ°ه›¾çڑ„ن»؟çœںم€‚ ه½“ه‰چçڑ„و¼”ç¤؛و—¨هœ¨ç”¨ن؛ژ AutonomouStuff هپœè½¦هœ؛هœ°ه›¾م€‚

è؟گè،Œè·ںè¸ھه™¨

转هˆ°â€œن»؟çœںâ€é،µé¢ï¼Œç‚¹ه‡»وµڈ览ه™¨çھ—هڈ£ن¸ٹçڑ„“è؟گè،Œن»؟çœںâ€وŒ‰é’®ن»¥هگ¯هٹ¨ن¸€ه¼€ه§‹هˆ›ه»؛çڑ„ن»؟çœںم€‚

è؟گè،Œن»¥ن¸‹هگ¯هٹ¨ه‘½ن»¤ن»¥هگ¯هٹ¨è·ںè¸ھه™¨ï¼Œ

| ros2 هگ¯هٹ¨ autoware_demos object_tracker_lidar_single_camera_lgsvl.launch.py |

é»ک认وƒ…ه†µن¸‹ï¼Œو¤ه‘½ن»¤ن½؟用 NDT ه®ڑن½چه™¨و¥èژ·هڈ–è‡ھوˆ‘车辆çٹ¶و€پم€‚ ن½†وک¯ NDT ه®ڑن½چه™¨éœ€è¦پن¸€ن¸ھن»…适用ن؛ژ AutonomouStuff ن»؟çœںه™¨هœ°ه›¾çڑ„点ن؛‘هœ°ه›¾م€‚ ه¦‚وœو‚¨وƒ³هœ¨ه…¶ن»–ن»؟çœںه™¨هœ°ه›¾ï¼ˆن¾‹ه¦‚ BorregasAve )ن¸è؟گè،Œè·ںè¸ھه™¨ï¼Œè¯·è؟گè،Œن»¥ن¸‹ه‘½ن»¤و¥ç¦پ用 NDT,

| ros2 هگ¯هٹ¨ autoware_demos object_tracker_lidar_single_camera_lgsvl.launch.py​​ use_ndt:=False |

è؟گè،Œن»¥ن¸‹هگ¯هٹ¨ه‘½ن»¤ن»¥هگ¯هٹ¨ه¸¦هڈŒو‘„هƒڈه¤´çڑ„è·ںè¸ھه™¨ï¼Œ

| ros2 هگ¯هٹ¨ autoware_demos object_tracker_lidar_dual_camera_lgsvl.launch.py |

è·ںè¸ھèٹ‚点

è؟™وک¯ tracking_nodes هŒ…装çڑ„设è®،و–‡ن»¶م€‚

ç›®çڑ„/用ن¾‹

è؟™وک¯هŒ…ه‘¨ه›´çڑ„ ROS ه±‚هŒ…装ه™¨ tracking م€‚

设è®،

DetectedObjects ه’Œï¼ˆهڈ¯é€‰ï¼‰ ClassifiedRoiArray و¶ˆوپ¯ن¸ژ Odometry وˆ– PoseWithCovarianceStamped و¶ˆوپ¯و—¶é—´هگŒو¥ï¼Œç„¶هگژه°†ه…¶è½¬هڈ‘هˆ°و›´و–°è½¨éپ“çٹ¶و€پçڑ„è·ںè¸ھه™¨ه®çژ°م€‚ 然هگژèژ·هڈ–ه¹¶هڈ‘ه¸ƒو›´و–°çڑ„و›²ç›®م€‚ هپ‡è®¾/ه·²çں¥é™گهˆ¶

- ه¦‚وœ use_vision 设置ن¸؛ True هˆ™è½¨éپ“هˆ›ه»؛ç–ç•¥ه°†è‡ھهٹ¨و›´و–°ن¸؛ LidarIfVision

- ه¦‚وœ use_vision 设置ن¸؛ True ه¹¶ن¸”و²،وœ‰وژ¥و”¶هˆ°è§†è§‰و¶ˆوپ¯ï¼Œهˆ™ن¸چن¼ڑهڈ‘ه¸ƒن»»ن½•è½¨éپ“,ه› ن¸؛هˆ›ه»؛ç–略需è¦پن¸ژ视觉ه…³èپ”

输ه…¥/输ه‡؛/API

输ه…¥ن¸»é¢کï¼ڑ

- “و£€وµ‹هˆ°çڑ„ه¯¹è±،â€

- “classified_roisâ€ï¼ˆهڈ¯é€‰ï¼‰

- “里程è®،â€

输ه‡؛ن¸»é¢کï¼ڑ

هڈ‚و•°ï¼ڑ

- use_vision - ه°†و¤è®¾ç½®ن¸؛ true ن»¥è®¢éک… ClassifiedRoiArray ن¸»é¢کم€‚ è؟™ن¹ںو„ڈه‘³ç€ vision_association 需è¦پهœ¨ params و–‡ن»¶ن¸ه®ڑن¹‰éƒ¨هˆ†

- use_ndt - ه°†و¤è®¾ç½®ن¸؛ true ن»¥ن½؟è·ںè¸ھه™¨ن½؟用 Odometry و¥è‡ھ NDT çڑ„ msgم€‚ False ه°†ن½؟è·ںè¸ھه™¨ن½؟用 PoseWithCovarianceStamped و¥è‡ھçڑ„ msg lgsvl_interface

وœ‰ه…³و¼”ç¤؛,请هڈ‚éک… ن½؟用 SVL ن»؟çœںه™¨è؟گè،Œه¤ڑه¯¹è±،è·ںè¸ھه™¨

و£€وµ‹هˆ°çڑ„ه¯¹è±،ه…³èپ”ه™¨

è؟™وک¯هœ¨ه¯¹è±،è·ںè¸ھèٹ‚点ن¸ن½؟用çڑ„و£€وµ‹هˆ°çڑ„ه¯¹è±،ه…³èپ”ه™¨çڑ„设è®،و–‡و،£

ç›®çڑ„/用ن¾‹

و£€وµ‹هˆ°çڑ„ه¯¹è±،ه…³èپ”ه™¨و¨،ه—ه°†و£€وµ‹ن¸ژ相ن¼¼çڑ„轨è؟¹é…چه¯¹ï¼Œن»¥ن¾؟هڈ¯ن»¥و›´ه¥½هœ°ن¼°è®،轨è؟¹çڑ„و–°çٹ¶و€پ,وˆ–者هڈ¯ن»¥هˆ›ه»؛و–°è½¨è؟¹وˆ–

ن؟®ه‰ھçژ°وœ‰è½¨è؟¹م€‚

设è®،

و£€وµ‹هˆ°çڑ„ه¯¹è±،ه…³èپ”ه™¨و¨،ه—ن½؟用马و°ڈè·ç¦»و¥è®،算轨éپ“ن¸ژو£€وµ‹çڑ„“相ن¼¼ç¨‹ه؛¦â€م€‚ و¤وˆگوœ¬ç”¨ن؛ژ解ه†³هŒˆç‰™هˆ©هˆ†é…چه™¨é—®é¢ک,该问é¢کè؟”ه›و£€وµ‹ه’Œè·ںè¸ھن¹‹é—´çڑ„ن¸€ه¯¹ن¸€ه…³èپ”م€‚ وںگن؛›è½¨è؟¹/و£€وµ‹هڈ¯èƒ½و²،وœ‰ن»»ن½•ه¯¹ه؛”çڑ„ه…³èپ”م€‚ هپ‡è®¾/ه·²çں¥é™گهˆ¶

- هپ‡è®¾و£€وµ‹وک¯ه…·وœ‰é零é¢ç§¯çڑ„ه‡¸ه¤ڑè¾¹ه½¢

- هپ‡è®¾و£€وµ‹çڑ„é،¶ç‚¹é€†و—¶é’ˆوژ’هˆ—

- 轨éپ“و¶ˆوپ¯ن¸çڑ„و¯ڈن¸ھ轨éپ“都وœ‰ن¸€ن¸ھه½¢çٹ¶هگ‘é‡ڈو¥و”¯وŒپé“°وژ¥ه¼ڈ车辆م€‚ ه…³èپ”者ن»…ن½؟用هگ‘é‡ڈن¸çڑ„第ن¸€ن¸ھه½¢çٹ¶و¥è؟›è،Œه…³èپ”

输ه…¥/输ه‡؛/API

输ه…¥ï¼ڑ

- و£€وµ‹هˆ—è،¨

- و›²ç›®هˆ—è،¨

هڈ‚و•°ï¼ڑ

- 轨è؟¹ن¸ژه…¶ç›¸ه…³و£€وµ‹ن¹‹é—´çڑ„وœ€ه¤§é¢ç§¯و¯”

- 轨éپ“ن¸ژه…¶ç›¸ه…³و£€وµ‹ن¹‹é—´ه…پ许çڑ„وœ€ه¤§و¬§ه‡ 里ه¾—è·ç¦»

- ه¸ƒه°”ه€¼ï¼Œç”¨ن؛ژوژ§هˆ¶هœ¨ه¤§ن؛ژé…چç½®çڑ„éکˆه€¼è·ç¦»çڑ„وƒ…ه†µن¸‹وک¯هگ¦ن½؟用و£€وµ‹çڑ„وœ€ه°ڈè¾¹ن½œن¸؛éکˆه€¼è·ç¦»

输ه‡؛

- è·ںè¸ھه’Œو£€وµ‹ن¹‹é—´çڑ„ه…³èپ”

وژ¥هڈ£ï¼ڑ

- 调用 assign() و£€وµ‹ه’Œè·ںè¸ھهˆ—è،¨م€‚

è؟™ه°†è؟”ه›ن¸€ن¸ھ结و„,ه…¶ن¸هŒ…هگ«ï¼Œ

- و¯ڈن¸ھ轨éپ“çڑ„相ه…³و£€وµ‹çڑ„ç´¢ه¼•ï¼Œوˆ–者 AssociatorResult::UNASSIGNED ه¦‚وœè½¨éپ“و— و³•ن¸ژن»»ن½•و£€وµ‹ç›¸ه…³èپ”

- و²،وœ‰ه…³èپ”轨è؟¹çڑ„و‰€وœ‰و£€وµ‹çڑ„ç´¢ه¼•

- و²،وœ‰ه…³èپ”و£€وµ‹çڑ„و‰€وœ‰trackçڑ„ç´¢ه¼•

ه†…部ه·¥ن½œ/ç®—و³•

- و‰¾ه‡؛وژ¥و”¶هˆ°çڑ„轨éپ“ه’Œو£€وµ‹çڑ„و•°é‡ڈه¹¶é€‚ه½“هœ°هˆه§‹هŒ–هˆ†é…چه™¨

- ه¾ھçژ¯و£€وµ‹ه’Œè·ںè¸ھم€‚ ه¯¹ن؛ژو¯ڈه¯¹و£€وں¥ه®ƒن»¬وک¯هگ¦هڈ¯ن»¥و ¹وچ®é…چç½®çڑ„هڈ‚و•°è؟›è،Œه…³èپ”

- ه¦‚وœن¸€ه¯¹و»،足门وژ§هڈ‚و•°ï¼Œهˆ™è®،ç®—ه®ƒن»¬ن¹‹é—´çڑ„马و°ڈè·ç¦»ه¹¶هœ¨هˆ†é…چه™¨ن¸ن¸؛该ه¯¹هˆ†é…چوƒé‡چم€‚ هگ¦هˆ™ï¼Œه؟½ç•¥è¯¥ه¯¹

- assign() هœ¨هˆ†é…چه™¨ن¸ 调用ه‡½و•°

- ه¾ھçژ¯éپچهژ†و‰€وœ‰ه…³èپ”ن»¥و‰¾ه‡؛و²،وœ‰ه…³èپ”çڑ„轨è؟¹ه’Œو£€وµ‹

错误و£€وµ‹ه’Œه¤„çگ†

- ه¦‚وœè½¨è؟¹وˆ–و£€وµ‹ه½¢çٹ¶ن¸چو»،足ن¸ٹè؟°هپ‡è®¾ï¼Œهˆ™وٹ›ه‡؛ه¼‚ه¸¸

وœھو¥çڑ„و‰©ه±•/وœھه®çژ°çڑ„部هˆ†

- 考虑ه¤ڑه¯¹ن¸€ه…³èپ”

- 考虑ه‡ ن½•ç›¸ن¼¼و€§ه؛¦é‡ڈ

相ه…³é—®é¢ک

ROIه…³èپ”ه™¨

و؟€ه…‰é›·è¾¾ه’Œé›·è¾¾و£€وµ‹وœ؛ه™¨ن؛؛ه‘¨ه›´çڑ„ 3D 物ن½“م€‚ ه¦‚وœè؟™ن؛›ه¯¹è±،çڑ„视觉وµ‹é‡ڈهڈ¯ç”¨ï¼Œهˆ™هڈ¯ن»¥ه°†ه®ƒن»¬ه…³èپ”èµ·و¥ن»¥هٹ ه¼؛ 3D ن؟،وپ¯م€‚

ç›®çڑ„/用ن¾‹

هڈ¯ن»¥é€ڑè؟‡èچهگˆو¥è‡ھ相ن؛’è،¥ه……çڑ„ه¤ڑç§چو¨،ه¼ڈçڑ„و•°وچ®و¥هٹ ه¼؛è·ںè¸ھم€‚ è®،ç®—وœ؛视觉وک¯و¤ç±»و¨،ه¼ڈن¹‹ن¸€ï¼Œه®ƒهڈ¯ن»¥وڈگن¾›وںگن؛›ن¼کهٹ؟,ن¾‹ه¦‚هœ¨é€‚ه½“ه…‰ç…§و،ن»¶ن¸‹èƒ½ه¤ںو¯”ه…¶ن»–ن¼ و„ںه™¨و›´ه¥½هœ°وڈگهڈ–è¯ن¹‰ن؟،وپ¯م€‚

ن¸؛ن؛†ه°†è§†è§‰و£€وµ‹ن¸ژ 3D و£€وµ‹ç»“هگˆن½؟用,需è¦پن¸€ن¸ھه…³èپ”ه™¨ï¼Œè¯¥ه…³èپ”ه™¨هڈ¯ن»¥ه°†ه›¾هƒڈن¸çڑ„ ROI ن¸ژ 3D و£€وµ‹ç›¸ه…³èپ”م€‚

设è®،

GreedyRoiAssociator ه°†é€ڑè؟‡é¦–ه…ˆه°†و¯ڈن¸ھ 3D ه¯¹è±،وٹ•ه½±هˆ°ه›¾هƒڈه¹³é¢ï¼Œç„¶هگژو ¹وچ®ه½“ه‰چ设置ن¸؛ IOUHeuristic çڑ„هŒ¹é…چه؛¦é‡ڈ选و‹©وœ€ن½³هŒ¹é…چو¥ه°† 3D ه¯¹è±،ن¸ژه›¾هƒڈن¸çڑ„ ROI ه…³èپ”م€‚ 3D و£€وµ‹هڈ¯ن»¥و¥è‡ھو؟€ه…‰é›·è¾¾م€پé›·è¾¾وˆ–ن»»ن½•ه…¶ن»–ن؛§ç”ں 3D 输ه‡؛çڑ„ن¼ و„ںه™¨ï¼Œن¹ںهڈ¯ن»¥وک¯è·ںè¸ھه™¨ن¸ه·²ç»ڈهکهœ¨çڑ„轨è؟¹م€‚ ه†…部ه·¥ن½œ/ç®—و³•

وœ‰ه…³ه¦‚ن½•و‰§è،Œوٹ•ه½±çڑ„و›´ه¤ڑ详细ن؟،وپ¯ï¼Œ 请هڈ‚éک… وٹ•ه½±و–‡و،£م€‚

预è®،و€»ه¤چو‚ه؛¦ه°†ç”±ه…³èپ”و“چن½œç،®ه®ڑ,ه…¶وœ€هڈوƒ…ه†µه¤چو‚ه؛¦ن¸؛ أک ( أ± هگ¨ أ± R ( ن؛” R + ن؛” هگ¨ ) ) هœ¨ه“ھ里 أ± هگ¨ وک¯ 3D ه¯¹è±،çڑ„و•°é‡ڈ, أ± R وک¯ ROI çڑ„و•°é‡ڈ, ن؛” R وک¯ ROI ن¸ٹçڑ„وœ€ه¤§é،¶ç‚¹و•°ï¼Œه¹¶ن¸” ن؛” هگ¨ وک¯ 3D ه¯¹è±،ن¸ٹçڑ„وœ€ه¤§é،¶ç‚¹و•°م€‚ ه¤چو‚و€§èƒŒهگژçڑ„解é‡ٹوک¯ï¼Œو¯ڈن¸ھه¯¹è±،都ن¸ژه¾ھçژ¯ن¸çڑ„و¯ڈن¸ھ ROI è؟›è،Œو¯”较,ه…¶ن¸هœ¨ IoU è®،ç®—وœںé—´è®،ç®—ه½¢çٹ¶çڑ„هŒ؛هںںم€‚ é¢ç§¯è®،ç®—çڑ„ه¤چو‚ه؛¦ç”±و¯ڈن¸ھه½¢çٹ¶çڑ„é،¶ç‚¹و•°ه†³ه®ڑ,و€»ه¤چو‚ه؛¦ن¸؛ أک ( ن؛” R + ن؛” هگ¨ ) ه¯¹ن؛ژو¯ڈن¸ھه¯¹è±،-ROI و¯”较م€‚

- ن¸چهœ¨ه›¾هƒڈه¹³é¢ن¸ٹçڑ„ه¯¹è±،ن¸چه…³èپ”

- و²،وœ‰هŒ¹é…چ ROI ه¯¹ه؛”ه¯¹è±،çڑ„ه¯¹è±،ن¸چه…³èپ”

- و²،وœ‰هŒ¹é…چه¯¹è±،ه¯¹ه؛”物çڑ„ ROI ن¸چه…³èپ”

- è¦په°† ROI ه’Œه¯¹è±،视ن¸؛هŒ¹é…چ,ه®ƒن»¬ن¹‹é—´çڑ„è®،ç®— IOU ه؟…é،»ه¤§ن؛ژéکˆه€¼م€‚

输ه…¥/输ه‡؛/API

输ه…¥ï¼ڑ

输ه‡؛ï¼ڑ

هœ¨ن»؟çœںه™¨ن¸è®،算相وœ؛çڑ„ه†…هœ¨ه‡½و•°

ن¼ و„ںه™¨ json و–‡ن»¶ه°†هŒ…هگ«è§†é‡ژ(ه®ƒوک¯ه‚ç›´ FOV)ه’Œç؛µو¨ھو¯”(ه®½ه؛¦ه’Œé«که؛¦ï¼‰م€‚ ن½؟用è؟™ن؛›و•°ه—è®،ç®—هڈ‚و•°ه¦‚ن¸‹ï¼Œ

a s p e c t _ r a t i o = w i d t h / h e i g ht _

éœچ里ه…¹ _ _ _ _ o n t a l_f _ _ o v = 2 * t a n − 1 ( هگ¨ ن¸€ أ± ( F 电هژ‹ _ / 2 ) * a s p e c t _ r a t i o )

F X = w وˆ‘ d t h / 2 * t a n ( 0.5 * h o r i z o n t a l_f _ _ o v )

F وک¯çڑ„ = h e i g h t / 2 * t a n ( 0.5 * F 电هژ‹ _ )

C X = w وˆ‘ d ه°ڈو—¶ / 2 _

C وک¯çڑ„ = h e i g ه°ڈو—¶ / 2 _ 相ه…³é—®é¢ک

- #983ï¼ڑهœ¨ه¯¹è±،è·ںè¸ھه™¨ن¸é›†وˆگ视觉و£€وµ‹

- #1244ï¼ڑه°†و؟€ه…‰é›·è¾¾é›†ç¾¤ن¸ژ视觉و£€وµ‹ç›¸ه…³èپ”

轨è؟¹ç”ںوˆگه™¨

ç›®çڑ„/用ن¾‹

è‡ھهٹ¨é©¾é©¶ç³»ç»ںçڑ„ه¯¹è±،è·ںè¸ھو¶‰هڈٹه°†و¯ڈن¸€ه¸§ن¸çڑ„و–°و£€وµ‹ن¸ژè·ںè¸ھه™¨è®°ه½•çڑ„轨è؟¹ç›¸ه…³èپ”م€‚ و¯ڈه¸§éƒ½وœ‰و–°ç‰©ن½“è؟›ه…¥è½¦è¾†çڑ„视é‡ژ,و„ںçں¥ن¼ و„ںه™¨ن¹ںهڈ¯èƒ½و¯ڈه¸§éƒ½وœ‰è¯¯وٹ¥م€‚ è؟™و„ڈه‘³ç€è·ںè¸ھه™¨éœ€è¦پن¸€ن¸ھو¨،ه—و¥è¯„ن¼°è؟™ن؛›ن¸چ符هگˆهŒ¹é…چو ‡ه‡†çڑ„و£€وµ‹ن»¥ن¸ژن»»ن½•çژ°وœ‰è½¨éپ“هŒ¹é…چم€‚ çگ†وƒ³وƒ…ه†µن¸‹ï¼Œè¯¥و¨،ه—هڈھ需è¦پن¸؛و¥è‡ھçœںه®ه¯¹è±،çڑ„و£€وµ‹هˆ›ه»؛و–°çڑ„è·ںè¸ھ,è·ںè¸ھه™¨هڈ¯ن»¥ه°†ه…¶ç؛³ه…¥ه…¶و“چن½œم€‚

设è®،

轨éپ“هˆ›ه»؛背هگژçڑ„و ¸ه؟ƒو€وƒ³وک¯وˆ‘ن»¬ن½؟用ç–ç•¥و¨،ه¼ڈ,ه…¶ن¸ه¤§éƒ¨هˆ†è½¨éپ“هˆ›ه»؛ه·¥ن½œه®é™…ن¸ٹ由轨éپ“هˆ›ه»؛ç–ç•¥ه¤„çگ†م€‚ autoware ::perception::tracking::TrackCreator ç±»ه°†ç–ç•¥ن½œن¸؛و¨،و؟هڈ‚و•°ï¼Œه¹¶هœ¨وژ¥و”¶هˆ°ç”¨ن؛ژهˆ›ه»؛轨éپ“çڑ„و•°وچ®و—¶è°ƒç”¨ه®ƒم€‚

笔记 虽然è؟™وک¯ن¸€ç§چه¤ڑو€پè،Œن¸؛,ن½†وˆ‘ن»¬ن½؟用编译و—¶ه¤ڑو€پ,ه› و¤è½¨éپ“هˆ›ه»؛و¨،ه—çڑ„输ه…¥ç±»ه‹çڑ„وœ‰و•ˆو€§هœ¨ç¼–译وœںé—´ه¾—هˆ°éھŒè¯پم€‚ه†…部ه·¥ن½œ/ç®—و³•

autoware ::perception::tracking::TrackCreator ç±»وœ¬è؛«ه¹¶و²،وœ‰هپڑه¤ھه¤ڑçڑ„ه·¥ن½œï¼Œن½†ه®ƒéپµه¾ھن»¥ن¸‹وڈڈè؟°çڑ„ç–ç•¥ن¹‹ن¸€ï¼ڑ

ن»…é™گو؟€ه…‰é›·è¾¾é›†ç¾¤

- و‰“ç”µè¯ create_tracks(const ObjectsWithAssociations & objects) م€‚ و¤و–¹و³•ه°†ن¸؛و¯ڈن¸ھوڈگن¾›çڑ„集群هˆ›ه»؛ن¸€ن¸ھ轨éپ“م€‚ è؟™é‡Œهڈھ考虑ن¸چن¸ژه…¶ن»–ن»»ن½•ن¸œè¥؟ه…³èپ”çڑ„集群م€‚

- ن½؟用و¤ç–ç•¥ن¸چ需è¦پوœ‰و•ˆçڑ„ GreedyRoiAssociator ه¯¹è±،وŒ‡é’ˆم€‚ هڈ¯ن»¥هˆه§‹هŒ–ن¸؛nullptr

- 该ç–ç•¥ن¸چن¼ڑه®çژ° و¶ˆوپ¯ç±»ه‹çڑ„ add_objects() هٹں能م€‚ ClassifiedROIArray 调用ه®ƒن¼ڑه¯¼è‡´وٹ›ه‡؛ه¼‚ه¸¸

و؟€ه…‰é›·è¾¾é›†ç¾¤IfVision

- add_objects() ن½؟用视觉و£€وµ‹و¶ˆوپ¯ه’Œè§†è§‰è·ںè¸ھه…³èپ”çڑ„结وœ 调用م€‚ و¤و–¹و³•ه°†éپچهژ†ن¸ژ轨éپ“و— ه…³çڑ„و¯ڈن¸ھ视觉و£€وµ‹ه¹¶ه°†ه…¶هکه‚¨هœ¨ه†…部م€‚ و¯ڈو¬،调用و¤ه‡½و•°و—¶ï¼Œéƒ½ن¼ڑهœ¨ه†…部هˆ›ه»؛ن¸€و،و–°çڑ„视觉و£€وµ‹و¶ˆوپ¯ه¹¶ه°†ه…¶وژ¨é€پهˆ°ç¼“هکن¸

- و‰“ç”µè¯ create_tracks(const ObjectsWithAssociations & objects) م€‚ و¤و–¹و³•ه°†é¦–ه…ˆه°è¯• max_vision_lidar_timestamp_diff ن»ژ LiDAR 集群 msg و ‡è®°ن¸و‰¾هˆ°è§†è§‰و£€وµ‹م€‚ ه¦‚وœه®ƒهڈ‘çژ°è؟™و ·çڑ„و¶ˆوپ¯ï¼Œه®ƒه°†ه°è¯•ه°† LiDAR 集群ه’Œè§†è§‰و£€وµ‹ç›¸ه…³èپ”م€‚ ن»…ن»ژن¸ژ视觉و£€وµ‹هŒ¹é…چçڑ„ LiDAR 集群هˆ›ه»؛و–°è½¨éپ“

- ن½؟用و¤ç–略需è¦پهœ¨ VisionPolicyConfig struct ه¯¹è±،ن¸هˆه§‹هŒ–ن¸€ن¸ھوœ‰و•ˆçڑ„ TrackCreatorConfig struct ه¯¹è±،م€‚

هڈ‚و•°

- TrackCreationPolicy - و ¹وچ®ن¸ٹè؟°è¯´وکژ选و‹©ن¸€é،¹هڈ¯ç”¨çڑ„ç–ç•¥

- é»ک认و–¹ه·®ه’Œه™ھه£°و–¹ه·® - è؟™ن؛›وک¯ç”¨ن؛ژهˆه§‹هŒ–و–° TrackedObject ه¯¹è±،çڑ„ه€¼

- VisionPolicyConfig - 需è¦پن¸؛ LidarClusterIfVision ç–ç•¥هˆه§‹هŒ–و¤ç»“و„

- ن»ژ base_link 转وچ¢ن¸؛相وœ؛

- iou_threshold - è®،ç®— LiDAR 集群ه’Œè§†è§‰و£€وµ‹çڑ„وœ€ه°ڈ IOU ه€¼

- 相وœ؛çڑ„ه†…هœ¨هڈ‚و•°

- max_vision_lidar_timestamp_diff - 视觉و£€وµ‹و¶ˆوپ¯وˆ³ه’Œ LiDAR 集群و¶ˆوپ¯وˆ³ن¹‹é—´çڑ„وœ€ه¤§ه·®ه¼‚è¦پ考虑ه…³èپ”

هپ‡è®¾/ه·²çں¥é™گهˆ¶

- 该و¨،ه—هپ‡ه®ڑ create_tracks و¯ڈو¬،و”¶هˆ° LiDAR ه¯¹è±،و¶ˆوپ¯و—¶éƒ½ن¼ڑ调用

- هپ‡è®¾و¨،ه—ن¸çڑ„و‰€وœ‰ه‡½و•°éƒ½ن»ژهگŒن¸€ن¸ھç؛؟程调用,除ن؛† add_objects(ClassifiedROIArray, ...) ن½؟用ç؛؟程ه®‰ه…¨و•°وچ®ç»“و„ه¹¶ن¸”هڈ¯ن»¥ن»ژن¸چهگŒç؛؟程调用

وœھو¥çڑ„و‰©ه±•/وœھه®çژ°çڑ„部هˆ†

- و”¯وŒپé›·è¾¾و£€وµ‹

- و”¯وŒپوœ؛ه™¨ه¦ن¹ LiDAR ه¯¹è±،و£€وµ‹

è·ںè¸ھوµ‹è¯•و،†و¶

è؟™وک¯ tracking_test_framework هŒ…装çڑ„设è®،و–‡ن»¶م€‚ ç›®çڑ„/用ن¾‹

وˆ‘ن»¬éœ€è¦پن¸€ن¸ھو•°وچ®ç”ںوˆگه’Œوµ‹è¯•و،†و¶و¥وµ‹è¯• AutowareAuto ن¸çڑ„ه¯¹è±،è·ںè¸ھو¨،ه—م€‚ 该و،†و¶ه؛”该ن½؟用وˆ·èƒ½ه¤ںهˆ›ه»؛ه…·وœ‰وک“ن؛ژه®ڑن¹‰çڑ„规范çڑ„وµ‹è¯•ç”¨ن¾‹م€‚ هپ‡è®¾/ه·²çں¥é™گهˆ¶

- çژ°هœ¨وˆ‘ن»¬هپ‡è®¾è·ںè¸ھهڈ‘ç”ںهœ¨ 2D ن¸م€‚ ه› و¤ï¼Œè¢«è·ںè¸ھçڑ„ه¯¹è±،被هپ‡ه®ڑن¸؛简هچ•çڑ„ 2D ه½¢çٹ¶م€‚

- ç؛؟çڑ„ه½¢çٹ¶ç”¨ه›؛ه®ڑçڑ„端点è،¨ç¤؛,ن¸چوک¯و— é™گçڑ„م€‚

API

该و،†و¶ه°†وڈگن¾› API 用ن؛ژن¸؛被è·ںè¸ھه¯¹è±،ç”ںوˆگو•°وچ®ï¼Œè؟™ن؛›و•°وچ®ه°†è¢«é¦ˆé€پهˆ°ç”¨ن؛ژè·ںè¸ھç®—و³•çڑ„هچ•ه…ƒوµ‹è¯•ن¸م€‚ ن»¥ن¸‹ه†…ه®¹هڈ¯è¢«è§†ن¸؛ه¾…ه®Œه–„çڑ„هˆç¨؟ï¼ڑ

1.è،Œن؛؛( const Eigen::Vector2f & starting_position,

const autoware::common::types::float32_t starting_speed,

const autoware::common::types::float32_torientation_deg ,

const autoware::common::types::float32_t turn_rate_deg_per_sec)

2.و±½è½¦( const Eigen::Vector2f & starting_position,

const autoware::common::types::float32_t starting_speed,

const autoware::common::types::float32_torientation_deg ,

const autoware::common::types::float32_t turn_rate_deg_per_sec,

const Eigen::Vector2f & size);

3. و؟€ه…‰é›·è¾¾( const Eigen::Vector2f & position, const uint32_t number_of_beams,

const autoware::common::types::float32_t max_range);

4. هœ؛و™¯ï¼ˆه¸¸é‡ڈو؟€ه…‰é›·è¾¾ & و؟€ه…‰é›·è¾¾ï¼Œه¸¸é‡ڈstd::vector<std::unique_ptr<TrackedObject>> & ه¯¹è±،);

5. autoware_auto_perception_msgs::msg::DetectedObjects Scene::get_detected_objects_array(

const bool most_only)ه¸¸é‡ڈ

6.و— و•ˆهœ؛و™¯::move_all_objects( const std::chrono::milliseconds dt_in_secs) |

ه†…部ه·¥ن½œ/ç®—و³•

- 该و،†و¶وڈگن¾›ن؛†ن¸€ن¸ھ称ن¸؛ Shape ç±»çڑ„ 2D ه½¢çٹ¶ç”ںوˆگه™¨وژ¥هڈ£ï¼Œç”¨ن؛ژهœ¨ 2D ن¸è،¨ç¤؛被è·ںè¸ھçڑ„ه¯¹è±،م€‚

- è؟™ن¸ھوٹ½è±،类由 و‰©ه±•è€Œو¥ , Line و¯ڈن¸ھç±» هˆ†هˆ«وک¯ LiDAR rayم€پو±½è½¦ه’Œè،Œن؛؛çڑ„程ه؛ڈهŒ–è،¨ç¤؛م€‚ è؟™ن؛›هگç±»ه®çژ°ن؛†ه®ƒن»¬è‡ھه·±çڑ„ه‡½و•°ç‰ˆوœ¬ï¼Œè¯¥ه‡½و•°è؟”ه› ن¸ژ çڑ„ن؛¤ç‚¹ , ن»ژ而و¨،ن»؟ه½“و¥è‡ھن¼ و„ںه™¨çڑ„ه…‰ç؛؟وژ¥è§¦ه¯¹è±،è،¨é¢و—¶è؟”ه›ه¯¹è±،ن¸ٹçڑ„è·ںè¸ھ点çڑ„è،Œن¸؛م€‚ Rectangle Circle intersect_with_line Line Rectangle Circle

- ن¸؛ن؛†èƒ½ه¤ںهˆه§‹هŒ– Line ه’Œن½؟用ه®ƒï¼Œوˆ‘ن»¬éœ€è¦پï¼ڑ起点è،¨ç¤؛ن¸؛ 2D هگ‘é‡ڈ [xs,ys],终点è،¨ç¤؛ن¸؛ 2D هگ‘é‡ڈ [xe,ye]م€‚ ç؛؟çڑ„و–¹هگ‘ه’Œé•؟ه؛¦ç”±هگو ‡ç³»ن¸çڑ„起点ه’Œç»ˆç‚¹ç،®ه®ڑم€‚

- ن¸؛ن؛†èƒ½ه¤ںهˆه§‹هŒ– Rectangle ه’Œن½؟用ه®ƒï¼Œوˆ‘ن»¬éœ€è¦پï¼ڑن¸ه؟ƒç‚¹è،¨ç¤؛ن¸؛ 2D هگ‘é‡ڈ [xc,yc] ه’Œه¤§ه°ڈ(é•؟ه؛¦ * ه®½ه؛¦ï¼‰è،¨ç¤؛ن¸؛ 2D هگ‘é‡ڈ [l, b] هٹ ن¸ٹو–¹هگ‘ [角ه؛¦] wrt x è½´ه؛¦و•°è،¨ç¤؛ن¸؛وµ®ç‚¹و•°م€‚ Rectangle çڑ„边界ه’Œè§’点ه°†ç”±وڈگن¾›çڑ„è؟™ن؛›è¾“ه…¥ç،®ه®ڑ,ه½“وˆ‘ن»¬ه°è¯•èژ·هڈ–ن¸ژ Line .

- ن¸؛ن؛†èƒ½ه¤ںهˆه§‹هŒ– Circle ه¹¶ن½؟用ه®ƒï¼Œوˆ‘ن»¬éœ€è¦پï¼ڑن¸ه؟ƒç‚¹è،¨ç¤؛ن¸؛ 2D هگ‘é‡ڈ [xc,yc],هچٹه¾„ [r] è،¨ç¤؛ن¸؛وµ®ç‚¹و•°م€‚

وœھو¥çڑ„و‰©ه±•/وœھه®çژ°çڑ„部هˆ†

- ه®çژ° 3D ه½¢çٹ¶ç”ںوˆگه™¨وژ¥هڈ£ه’Œèژ·هڈ–ن؛¤ç‚¹çڑ„و–¹و³•م€‚

- éھŒè¯پè·ںè¸ھه™¨è¾“ه‡؛çڑ„و–¹و³•

- ن¸؛é›·è¾¾ç‰ه…¶ن»–ن¼ و„ںه™¨و¨،ه¼ڈç”ںوˆگه¯¹è±،

相ه…³é—®é¢ک

https://gitlab.com/autowarefoundation/autoware.auto/AutowareAuto/-/issues/886

预وµ‹

هڈ¯ن»¥ن½؟用ن»ژ点çڑ„ 3D ن½چç½®ه’Œç›¸وœ؛çڑ„ه†…هœ¨ه‡½و•°ه¯¼ه‡؛çڑ„ه‡ ن½•و¯”ن¾‹و¥ن¼°è®، 3D 点هœ¨ه›¾هƒڈه¹³é¢ن¸ٹçڑ„وٹ•ه½±م€‚

ç›®çڑ„/用ن¾‹

هڈ¯ن»¥é€ڑè؟‡ه°† 3D 点وٹ•ه½±هˆ°ç›¸ه؛”çڑ„ه›¾هƒڈه¹³é¢و¥ن¼°è®، 3D 点çڑ„هƒڈç´ ه¯¹ه؛”ه…³ç³»م€‚ è؟™ه¯¹ن؛ژه°†ç©؛é—´ن¸çڑ„ه‡ ن½•ç»“و„ن¸ژه›¾هƒڈن¸ٹوچ•èژ·çڑ„ه‡ ن½•ç»“و„相ه…³èپ”ه¾ˆوœ‰ç”¨م€‚

设è®،

点çڑ„وٹ•ه½±وک¯é€ڑè؟‡ه؛”用وٹ•ه½±çں©éکµو¥ه®Œوˆگçڑ„ 磷 ï¼ڑ

خ» âژ، âژ£ âژ¢ X p وک¯çڑ„ p 1 âژ¤ âژ¦ âژ¥ = P âژ، âژ£ âژ¢ âژ¢ âژ¢ X وک¯ Z 1 âژ¤ âژ¦ âژ¥ âژ¥ âژ¥

( X , Y , Z ) وک¯è¯¥ç‚¹çڑ„ 3D هگو ‡ï¼Œه¹¶ن¸” ( X p , وک¯çڑ„ p ) وک¯وٹ•ه½±çڑ„هƒڈç´ هگو ‡م€‚ خ» وک¯ç‚¹ç›¸ه¯¹ن؛ژ相وœ؛ه¸§çڑ„و·±ه؛¦م€‚

磷 هڈ¯ن»¥ن½؟用ه†…هœ¨çں©éکµè®،ç®— ؤ· ه’Œ ego-to-camera هڈکوچ¢ هگ¨ و ¹وچ®ç‰ه¼ڈ 磷 = K هگ¨ . ه†…هœ¨çں©éکµه®ڑن¹‰ه¦‚ن¸‹ï¼ڑ

ؤ· = âژ، âژ£ âژ¢ F X 0 0 s F وک¯çڑ„ 0 â—‹ X â—‹ وک¯çڑ„ 1 âژ¤ âژ¦ âژ¥

F X ه’Œ F وک¯çڑ„ وک¯ن»¥هƒڈç´ ن¸؛هچ•ن½چçڑ„ x ه’Œ y è½´ن¸ٹçڑ„焦è·م€‚ s وک¯هƒڈç´ هپڈ移ه› هگم€‚ â—‹ X ه’Œ â—‹ وک¯çڑ„ وک¯هƒڈç´ ن¸»ç‚¹هپڈ移م€‚ è؟™ن؛›هڈ‚و•°هڈ¯ن»¥é€ڑè؟‡و ،ه‡†ç”ںوˆگه›¾هƒڈçڑ„特ه®ڑ相وœ؛و¥وµ‹é‡ڈم€‚ ه†…部ه·¥ن½œ/ç®—و³•

é€ڑè؟‡و‰§è،Œن»¥ن¸‹و¥éھ¤ه®Œوˆگوٹ•ه½±ï¼ڑ

- ن½؟用相وœ؛هڈکوچ¢ه’Œه†…هœ¨ه‡½و•°و„é€ وٹ•ه½±çں©éکµ

- وٹ•ه½±ن»£è،¨ 3D ه½¢çٹ¶çڑ„و‰€وœ‰é،¶ç‚¹

- 相وœ؛هگژé¢çڑ„点被è؟‡و»¤وژ‰

- è®،ç®—ه›´ç»•وٹ•ه½±ç‚¹çڑ„ه‡¸هŒ…م€‚

- و‰¾هˆ°ه‡¸هŒ…ه’Œه›¾هƒڈç”»ه¸ƒن¹‹é—´çڑ„ن؛¤ç‚¹

- è؟”ه›ç›¸ن؛¤çڑ„ه‡¸ه½¢ن½œن¸؛ه›¾هƒڈه¹³é¢ن¸ٹçڑ„وٹ•ه½±

输ه…¥/输ه‡؛/API

输ه…¥ï¼ڑ

- 相وœ؛ه†…هœ¨ه‡½و•°

- 相وœ؛هڈکوچ¢

- autoware_auto_perception_msgs::msg::Shape è،¨ç¤؛ 3D ه½¢çٹ¶م€‚

输ه‡؛ï¼ڑ

- è،¨ç¤؛وٹ•ه½±ه½¢çٹ¶çڑ„é،¶ç‚¹هˆ—è،¨م€‚

相ه…³é—®é¢ک

- #983ï¼ڑهœ¨ه¯¹è±،è·ںè¸ھه™¨ن¸é›†وˆگ视觉و£€وµ‹

|